Con la pandemia del coronavirus, probablemente dos de las mayores preocupaciones globales de 2020 han sido la privacidad de los datos personales y el uso de técnicas de reconocimiento facial, impulsadas por el auge de la inteligencia artificial y el aprendizaje automático.

Múltiples plataformas y aplicaciones han sido puestas en entredicho por recopilar fotografías para construir modelos de reconocimiento facial, entre las que destacan la startup estadounidense Clearview.ai o la aplicación rusa FaceApp.

Según The New York Times, Clearview AI descargó miles de millones de fotos en línea para crear una herramienta policial que permite conocer el nombre de una persona y la información de contacto, incluyendo su perfil en Facebook, solo con una fotografía. En tanto, FaceApp es una app que se popularizó a mediados de 2020 por aplicar filtros a las imágenes, pero que fue acusada de recopilar y almacenar los datos de los usuarios.

Cómo engañar a la inteligencia artificial

Con el objetivo de evitar estos riesgos, la Universidad de Chicago desarrolló un algoritmo y una herramienta de software (que se ejecuta localmente en la computadora), que limita la capacidad que tienen las redes neuronales profundas (llamadas en inglés Deep Neural Network, DNN) para rastrear rostros a partir de imágenes.

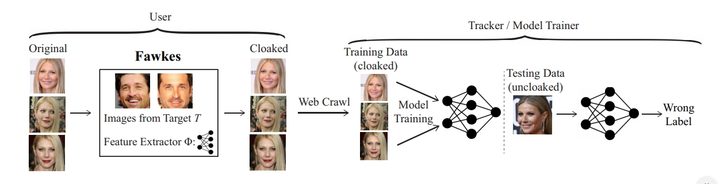

La aplicación denominada Fawkes toma las fotografías originales y les realiza pequeños cambios a nivel de píxeles, que resultan imperceptibles para el ojo humano, en un proceso llamado «encubrimiento».

Las imágenes «ocultas» pueden ser usadas como se hace con cualquier otra fotografía, compartiéndolas en las redes sociales, enviándolas a amigos, imprimiéndolas o mostrándolas en dispositivos digitales.

La diferencia es que si alguien intenta usarlas para construir un sistema de reconocimiento facial, las imágenes «ocultas» mostrarán una versión altamente distorsionada de la original.

El efecto de la capa no es detectable por humanos o máquinas, asegura el Laboratorio SAND de la Universidad de Chicago.

“El talón de Aquiles de los DNN ha sido este fenómeno llamado ejemplos adversos, pequeños ajustes en las entradas que pueden producir grandes diferencias en cómo los DNN clasifican la entrada (…) Son extremadamente difíciles de eliminar y, en cierto modo, son una consecuencia fundamental del entrenamiento imperfecto de los DNN”, afirman los desarrolladores.

Según el Laboratorio SAND de la Universidad de Chicago, Fawkes ha demostrado su eficacia en una variedad de entornos y es 100 por ciento efectivo contra los modelos de reconocimiento facial más modernos (Microsoft Azure Face API, Amazon Rekognition y Face ++).

La aplicación será presentada en el Simposio de Seguridad USENIX, uno de los mayores eventos de seguridad informática del mundo, que se realizará del 12 al 14 de agosto de 2020.