Los vehículos autónomos son cada vez más sofisticados, pero aún abundan las preocupaciones sobre su seguridad. Y es que desarrollar un sistema autónomo que conduzca de manera segura en condiciones de laboratorio es una cosa, pero confiar en que podrán hacerlo de la misma forma en el mundo real es algo totalmente distinto.

Investigadores del Instituto de Tecnología de Massachusetts (MIT) han estado observando las diferencias entre cómo los sistemas autónomos aprenden en el entrenamiento y los problemas que surgen cuando salgan al mundo real. Para ello, desarrollaron un modelo en que las situaciones que un sistema autónomo ha aprendido no coinciden con lo que efectivamente ocurre en la carretera.

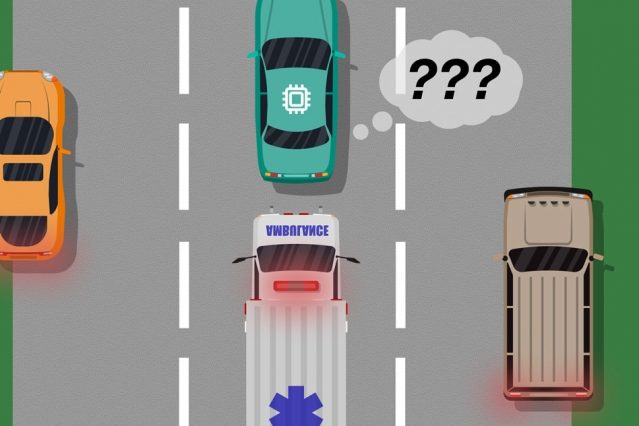

Un ejemplo es entender la diferencia entre un gran automóvil blanco y una ambulancia. Si un automóvil robotizado no ha sido entrenado o no tiene los sensores para comprender las diferencias entre ambos, es posible que no sepa que debe disminuir la velocidad y detenerse cuando se acerca el vehículo de emergencia. Los investigadores describen este tipo de escenarios como “puntos ciegos”.

Para identificarlos, los investigadores utilizaron aportes humanos para supervisar la inteligencia artificial (IA) durante el entrenamiento y para entregar retroalimentación sobre cualquier error que cometiera el sistema. El feedback humano se puede comparar con los datos del entrenamiento de la IA para identificar cualquier situación en la que necesite más o mejor información para tomar decisiones seguras y correctas.

«El modelo ayuda a los sistemas autónomos a saber mejor lo que no saben», dijo Ramya Ramakrishnan, un estudiante graduado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial y autor del artículo. “Muchas veces, cuando se implementan estos sistemas, las simulaciones no coinciden con las del mundo real [y] podrían cometer errores, como por ejemplo, involucrarse en accidentes. La idea es usar a los humanos para cerrar esa brecha entre la simulación y el mundo real de manera segura, para que podamos reducir algunos de esos errores», añadió.

Esto también puede funcionar en tiempo real, con una persona en el asiento del conductor de un vehículo autónomo. Mientras la IA esté maniobrando el coche correctamente, la persona no hace nada, pero si detecta un error, puede tomar el volante, lo que le indica al sistema que cometió un error. Esto le enseñará a la inteligencia artificial en qué situaciones existen diferencias entre cómo debe comportarse y lo que un conductor humano considera una conducción segura y responsable.

Actualmente, el sistema solo se ha probado en entornos de videojuegos virtuales, por lo que el siguiente paso es llevar el sistema a la carretera y usarlo en vehículos reales.