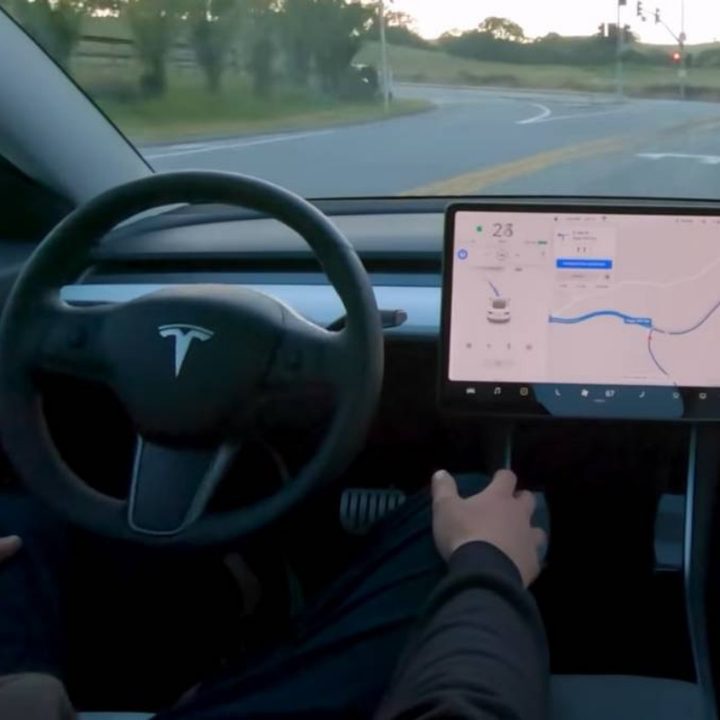

No son buenos tiempos para el sistema Autopilot de Tesla. Una investigación reveló que la función puede ser engañada para que el automóvil funcione sin que haya un conductor detrás del volante.

La denuncia de la revista Consumer Reports consideró un análisis de ingenieros, que probaron un Model Y en una pista cerrada y concluyeron que el sistema se puede “engañar con facilidad”.

Según la publicación, engañaron en repetidas ocasiones al automóvil para lograr que condujera sin que nadie estuviera sentado en el asiento del conductor.

Tesla asegura que el Autopilot es un sistema avanzado de asistencia al conductor, pero que requiere que una persona esté sentada detrás del volante y atenta a las condiciones de tránsito.

Según la compañía, entre los requisitos para activar Autopilot se encuentran la necesidad de mantener las manos en el volante, abrocharse el cinturón de seguridad y no abrir ninguna puerta.

“No solo falló en asegurarse de que el conductor estuviera prestando atención, sino que tampoco pudo decir si había un conductor”, dijo Jake Fishe, director de pruebas de Consumer Reports. Agregó que las medidas de seguridad eran “claramente insuficientes” para evitar que el vehículo funcionara sin un pilo.

La denuncia de Consumer Reports se suma a la de un hacker, que en marzo de 2021 también había engañado al sistema Autopilot con una fotografía del propio Elon Musk.

Accidente fatal

El hallazgo se produce días después de que dos personas murieran en un accidente de un vehículo de Tesla en Texas, Estados Unidos. Según la policía, al momento del siniestro no había ninguna persona detrás del volante, aunque el fundador de Tesla, Elon Musk, dijo que Autopilot no estaba activado.

La Administración Nacional de Seguridad del Tráfico en las Carreteras de Estados Unidos (NHTSA) ya abrió una investigación sobre el accidente en Texas, que se suma a otros 28 incidentes en los que se han visto involucrados vehículos de Tesla.