Se van despejando las incógnitas respecto a las razones que habrían gatillado la petición de salida de Sam Altman de OpenAI, ya que se filtró hace unas horas que una carta de la junta directiva puso en evidencia un proyecto secreto que estaba trabajando el equipo del destituido y luego retornado CEO, de una IA muy poderosa capaz de dañar la integridad de la humanidad: el proyecto Q*.

Según una de las fuentes, la veterana ejecutiva Mira Murati mencionó el proyecto, llamado Q* (pronunciado Q-Star), a los empleados el miércoles y dijo que se había enviado una carta al consejo antes de los acontecimientos del reciente fin de semana.

Tras la publicación de la noticia, una portavoz de OpenAI dijo que Murati había comunicado a los empleados lo que los medios iban a informar, pero no hizo comentarios sobre la exactitud de la información.

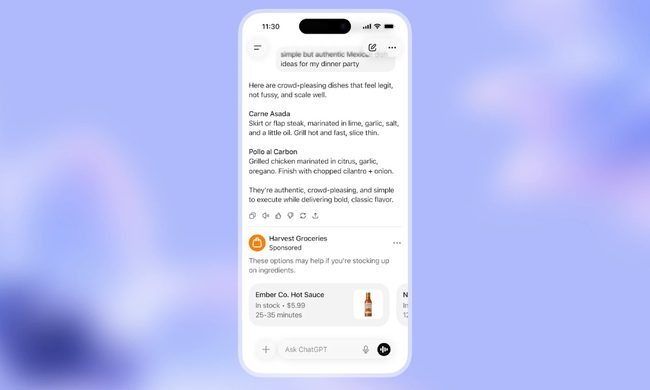

De qué se trata exactamente Q*

Q* fue descrita como una superinteligencia (AGI), según dos fuentes cercanas al directorio de OpenAI citadas por Reuters, y este adjetivo tenía concordancia con sus capacidades.

El nuevo modelo, dotado de vastos recursos informáticos, fue capaz de resolver algunos problemas matemáticos, dijo la persona bajo condición de anonimato por no estar autorizada a hablar en nombre de la empresa.

Si bien solo resuelve operaciones matemáticas para estudiantes de primaria, el hecho de superar estas pruebas hace que los investigadores sean muy optimistas sobre el futuro éxito de Q*, según la fuente.

Como sostiene Reuters: «Lograr la capacidad de hacer cálculos matemáticos —donde solo hay una respuesta correcta— implica que la IA tendría una mayor capacidad de razonamiento, que semejaría a la inteligencia humana. Esto podría aplicarse, por ejemplo, a nueva investigación científica, creen los investigadores de la IA. A diferencia de una calculadora que puede resolver un número limitado de operaciones, la IAG puede generalizar, aprender y comprender».

Que decía Sam Altman de los peligros de la IA

En junio de este 2023, Sam Altman se refirió a los peligros de la IA y describió que una agencia nuclear debería visar estos proyectos a futuro, como la Agencia Internacional de Energía Atómica de la ONU.

«El desafío que tiene el mundo es cómo vamos a manejar esos riesgos y asegurarnos de que aún podamos disfrutar de esos tremendos beneficios. Nadie quiere destruir el mundo».

La AGI, inteligencia artificial general, también fue abordada por Altman en un comunicado hace meses en OpenAI.

Las AGI son «capaces de elevar a la humanidad, aumentando la abundancia y el descubrimiento de nuevos conocimientos científicos«. Según la empresa, esto significa que todo el mundo puede tener acceso y ayuda con «casi cualquier tarea cognitiva«.

En la misma publicación, escrita por Altman y con fecha de febrero de 2023, el CEO acepta que las AGI pueden «ocurrir pronto o en un futuro lejano«. Por lo tanto, se debe gestionar una transición gradual para «experimentar los beneficios y las desventajas de los sistemas» y llegar a acuerdos sobre cómo se deben gobernar estos sistemas.