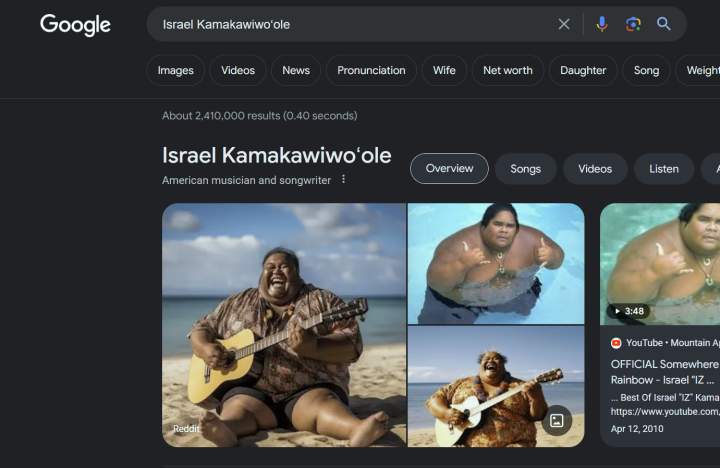

En este momento, si escribes «Israel Kamakawiwoʻole» en la búsqueda de Google, no ves una de las famosas portadas de álbumes del cantante, o una imagen de él interpretando una de sus canciones en su icónico ukelele. Lo primero que se ve es una imagen de un hombre sentado en una playa con una sonrisa en su rostro, pero no una foto del hombre en sí tomada con una cámara. Esta es una foto falsa generada por IA. De hecho, cuando haces clic en la imagen, te lleva al subreddit de Midjourney, donde se publicó inicialmente la serie de imágenes.

Esto fue publicado por primera vez por Ethan Mollick en X (antes conocido como Twitter), un profesor de Wharton que estudia IA.

Mirando la foto de cerca, no es difícil ver todos los rastros de IA que quedan en ella. El efecto de profundidad de campo falsa se aplica de manera desigual, la textura de su camisa es confusa y, por supuesto, le falta un dedo en la mano izquierda. Pero nada de eso es sorprendente. A pesar de lo buenas que se han vuelto las imágenes generadas por IA en el último año, siguen siendo bastante fáciles de detectar cuando se mira de cerca.

El verdadero problema, sin embargo, es que estas imágenes aparecen como el primer resultado de una figura famosa y conocida sin marcas de agua ni indicios de que sea generada por IA. Google nunca ha garantizado la autenticidad de los resultados de su búsqueda de imágenes, pero hay algo que se siente muy preocupante al respecto.

Ahora bien, hay algunas explicaciones posibles de por qué sucedió esto en este caso en particular. La cantante hawaiana, comúnmente conocida como Iz, falleció en 1997, y Google siempre quiere proporcionar la información más reciente a los usuarios. Pero dado que no se han publicado muchos artículos nuevos o discusiones sobre Iz desde entonces, no es difícil ver por qué el algoritmo recogió esto. Y aunque no se siente particularmente importante para Iz, no es difícil imaginar algunos ejemplos que serían mucho más problemáticos.

Incluso si no seguimos viendo que esto suceda a gran escala en los resultados de búsqueda, es un excelente ejemplo de por qué Google necesita tener reglas en torno a esto. Como mínimo, parece que las imágenes generadas por IA deberían marcarse claramente de alguna manera antes de que las cosas se salgan de control. Al menos, danos una forma de filtrar automáticamente las imágenes de IA. Sin embargo, dado el propio interés de Google en el contenido generado por IA, hay razones para pensar que puede querer encontrar formas de colar contenido creado por IA en sus resultados y no marcarlo claramente.