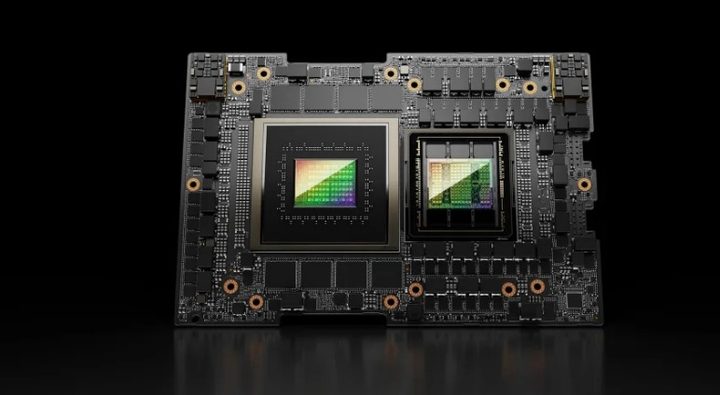

La gente de NVIDIA ha presentado este lunes 13 de noviembre su nueva generación de chips de supercomputadora IA, los GPU HGX H200 de la serie arquitectura Hopper y que desempeñarán un papel importante en futuros avances en aprendizaje profundo y grandes modelos de lenguaje (LLM) como GPT-4 de OpenAI.

Estos chips están pensados para centros de datos y supercomputadoras, trabajando en tareas como la predicción del tiempo y el clima, el descubrimiento de fármacos, la computación cuántica y más.

La GPU HGX H200 es un reemplazo de la popular GPU H100. Es el primer chip de la compañía que utiliza memoria HBM3e que es más rápida y tiene más capacidad, lo que lo hace más adecuado para modelos de lenguaje grandes. «Con HBM3e, la NVIDIA H200 ofrece 141 GB de memoria a 4,8 terabytes por segundo, casi el doble de capacidad y 2,4 veces más ancho de banda en comparación con su predecesora, la NVIDIA A100», escribió la compañía.

En términos de beneficios para la IA, NVIDIA dice que el HGX H200 duplica la velocidad de inferencia en Llama 2, un LLM de 70 mil millones de parámetros, en comparación con el H100. Estará disponible en configuraciones de 4 y 8 vías que son compatibles tanto con el software como con el hardware de los sistemas H100. Funcionará en todo tipo de centros de datos (on-premise, nube, nube híbrida y edge), y será desplegado por Amazon Web Services, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure, entre otros. Está previsto que llegue en el segundo trimestre de 2024.

El otro producto clave de NVIDIA es el «superchip» GH200 Grace Hopper que combina la GPU HGX H200 y la CPU NVIDIA Grace basada en Arm utilizando la interconexión NVLink-C2C de la compañía. Está diseñado para supercomputadoras para permitir que «los científicos e investigadores aborden los problemas más desafiantes del mundo acelerando las complejas aplicaciones de IA y HPC que ejecutan terabytes de datos», escribió NVIDIA.

La GH200 se utilizará en «40+ supercomputadoras de IA en centros de investigación globales, fabricantes de sistemas y proveedores de nube», dijo la compañía, incluidos Dell, Eviden, Hewlett Packard Enterprise (HPE), Lenovo, QCT y Supermicro. Entre ellos destacan los superordenadores Cray EX2500 de HPE, que utilizarán cuatro GH200, escalando hasta decenas de miles de nodos Grace Hopper Superchip.