Nvidia acaba de anunciar el AI Workbench, que promete hacer que la creación de IA generativa sea mucho más fácil y manejable. El espacio de trabajo permitirá a los desarrolladores hacer e implementar dichos modelos en varias plataformas de IA de Nvidia, incluidas PC y estaciones de trabajo. ¿Estamos a punto de ser inundados con aún más contenido de IA? Tal vez no, pero ciertamente parece que AI Workbench hará que todo el proceso sea significativamente más accesible.

En el anuncio, Nvidia señala que hay cientos de miles de modelos preentrenados actualmente disponibles; Sin embargo, personalizarlos requiere tiempo y esfuerzo. Aquí es donde entra en juego el Workbench, simplificando el proceso. Los desarrolladores ahora podrán personalizar y ejecutar IA generativa con un mínimo esfuerzo, utilizando todos los modelos de nivel empresarial necesarios. La herramienta Workbench admite varios marcos, bibliotecas y SDK de la propia plataforma de IA de Nvidia, así como repositorios de código abierto como GitHub y Hugging Face.

Una vez personalizados, los modelos se pueden compartir en múltiples plataformas con facilidad. Los desarrolladores que ejecutan una PC o estación de trabajo con una tarjeta gráfica Nvidia RTX podrán trabajar con estos modelos generativos en sus sistemas locales, pero también escalar a recursos de centro de datos y computación en la nube cuando sea necesario.

«Nvidia AI Workbench proporciona un camino simplificado para que los equipos interorganizacionales creen las aplicaciones basadas en IA que se están volviendo cada vez más esenciales en los negocios modernos», dijo Manuvir Das, vicepresidente de computación empresarial de Nvidia.

Nvidia también ha anunciado la cuarta iteración de su plataforma de software Nvidia AI Enterprise, que tiene como objetivo ofrecer las herramientas necesarias para adoptar y personalizar la IA generativa. Esto se divide en múltiples herramientas, incluida Nvidia NeMo, que es un marco nativo de la nube que permite a los usuarios crear e implementar modelos de lenguaje grandes (LLM) como ChatGPT o Google Bard.

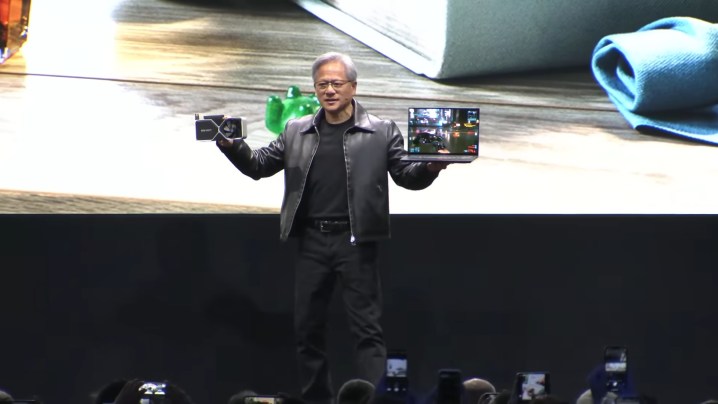

Nvidia está aprovechando el mercado de la IA cada vez más en el momento justo, y no solo con Workbench, sino también con herramientas como Nvidia ACE para juegos. Con los modelos generativos de IA como ChatGPT que están de moda en este momento, es seguro asumir que muchos desarrolladores podrían estar interesados en la solución fácil de ventanilla única de Nvidia. Aún está por verse si eso es algo bueno para el resto de nosotros, ya que algunas personas usan la IA generativa con fines cuestionables.

No olvidemos que la IA puede desquiciarse por sí sola, como en los primeros días de Bing Chat, y cuantas más personas comiencen a crear y entrenar estos diversos modelos, más casos de comportamiento problemático o loco veremos en la naturaleza. Pero suponiendo que todo vaya bien, AI Workbench de Nvidia ciertamente podría simplificar el proceso de implementación de una nueva IA generativa para muchas empresas.