La noticia sobre la primera víctima fatal por un accidente en el cual está involucrado un carro autónomo de Uber, ha despertado una ola de desconfianza hacia este nuevo tipo de tecnología que las grandes empresas de tecnología están probando en varias ciudades de los Estados Unidos.

Como consecuencia, Uber canceló estas pruebas y otras empresas, como Toyota, que están haciendo sus propias pruebas han empezarlo a hacerlo también.

Una de las soluciones para evitar más accidentes es que estos autos aprendan en simuladores en lugar de hacerlo en las calles e involucrándose en accidentes como estos. Por eso, nos pusimos en contacto con Danny Atsmon de Cognata, una de las empresas que desarrolla simulaciones para carros autónomos.

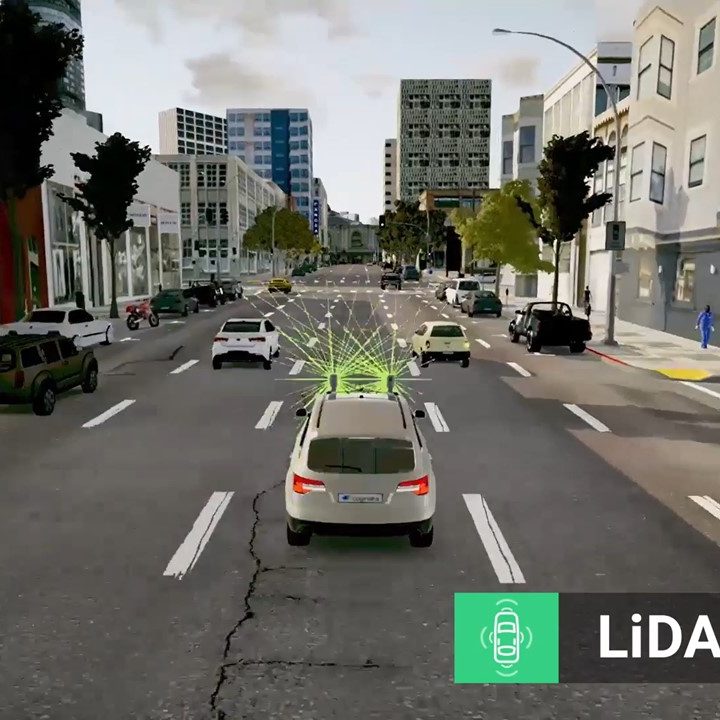

Estas plataformas permiten que los autos aprendan en las computadoras antes de ir a la calle. Atsmon indica que los carros autónomos deben conducir 11,000 millones de millas de pruebas, lo cual tomará años y lo que además si quiere lograr con este tipo de simulaciones es que la tecnología logre conducir todas esas millas más rápidamente.

Para tener una perspectiva, según cifras de este empresa, hasta el 2016 todas las compañías que están haciendo estas pruebas han conducido un total de 700,000 millas. Así que falta mucho por delante.

La muerte de un peatón es algo serio, sobre todo cuando se trata de nuevas tecnologías que siguen en periodos de prueba. En estos casos, es fácil culpar a las empresas de tecnología por no tener sus algoritmos lo suficientemente inteligentes con el fin de evitar este tipo de accidentes.

Sin embargo, hay que tener en cuenta que el accidente fue provocado por la mujer, que atravesó la calle donde no debía hacerlo. El carro autónomo de Uber tiene en su algoritmo la regla de que los peatones deben atravesar la calle por el paso de peatones y no en la mitad de la calle.

Todos en algún momento hemos atravesado una calle en sitios donde no debemos hacerlo. De cierta forma, es evidente que si este tipo de máquinas van a interactuar silenciosamente con seres humanos, deben saber que somos irracionales y que cosas así pueden suceder. En teoría, el carro debería haber detectado a la mujer y debería haber frenado a tiempo.

Sin embargo, el video publicado ayer por la policía de Tempe, Arizona, lugar donde sucedió el accidente, deja más preguntas que respuestas. Aún cuando la mujer apareció en frente, no parece haber ningún indicio de que el auto haya intentado frenar. Ella ya había cruzado una gran porción de la calle y es extraño que ningún sensor del auto la haya detectado, más aún cuando iba con una bicicleta.

El problema que parece haber en este caso es que es un auto que, al igual que un niño, está aprendiendo de su entorno. El algoritmo está todavía encontrando nueva información y procesándola. Es prácticamente imposible que los ingenieros tengan absolutamente todos los posibles escenarios catastróficos pensados de antemano.

Por eso, es que Atsmon afirma que el Dynamic Module en su simulación “toma el comportamiento de los conductores y simulan lo que los peatones hacen. Cosas que no deben suceder, suceden. El problema es que hay cientos y cientos de escenarios que puede haber. No significa que no debes culpar al auto sino que este no debería estar involucrado en esta situación en primer lugar”.

Para lograrlo, Atsmon afirma que la única forma de crear escenarios es crear un modelo para cada ciudad. “Cada ciudad es distinta y cada cual tiene su propia conducta tras el volante. Conducir en Palo Alto no es lo mismo que conducir en Shanghai o Bangalore (India)”, afirma Atsmon.

Claramente no todo es perfecto y en este caso suponemos que funciona como una clase: la simulación funciona como una teoría que se pone en práctica en la calle y de cierta forma, al utilizar simulaciones estaríamos poniendo toda la fe en la precisión de estas simulaciones. ¿Cómo garantizar que sean precisas? A la larga, el diseño sigue dependiendo de ingenieros y cómo se construyen estas redes neuronales que aprenden por sí solas.