Los drones han cambiado miles de patrones en el mundo, desde la vigilancia, hasta las grabaciones audiovisuales, pasando por traslado de objetos y víveres y muchas otras funciones que los humanos han comenzado a delegar a estos robots aéreos.

Y una de las cosas fascinantes de estos aparatos es el modo en que podemos controlarlos, lo que ha desembocado en que cada vez se prueben más niveles para hacer este ejercicio de forma más autónoma.

Eso es lo que ideó el Instituto Tecnológico de Massachusetts (MIT) y su equipo del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) , que diseñó un sistema llamado «Conduct-A-Bot», que utiliza señales musculares humanas de sensores portátiles para pilotar el movimiento de un dron.

Daniela Rus, profesora del MIT y directora de CSAIL, y coautora de un documento sobre el sistema, se refirió al programa y comentó que «visualizamos un mundo en el que las máquinas ayudan a las personas con el trabajo cognitivo y físico, y para hacerlo, se adaptan a las personas en lugar de al revés».

Cómo funciona Conduct-A-Bot

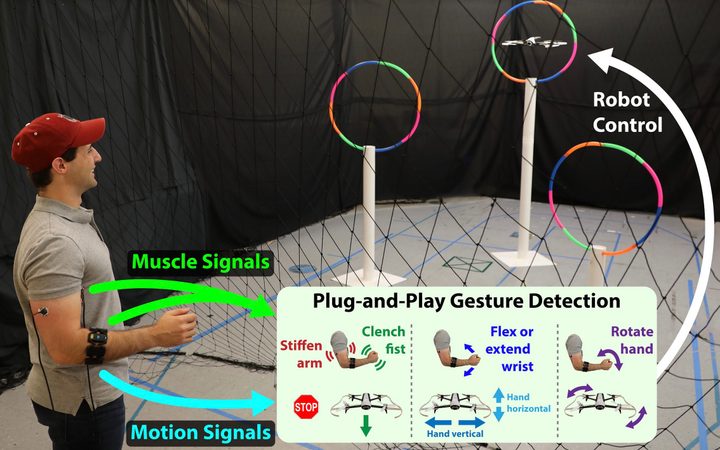

Este sistema de movimiento del dron mediante señales musculares usa electromiografía (EMG) y sensores de movimiento en los bíceps, tríceps y antebrazos para medir el movimiento. Luego, los algoritmos procesan las señales para detectar gestos en tiempo real, sin ninguna calibración fuera de línea o datos de entrenamiento por usuario. El sistema usa solo dos o tres sensores portátiles y nada en el entorno, lo que reduce en gran medida la barrera para los usuarios ocasionales que interactúan con los robots.

Al detectar acciones como gestos de rotación, puños cerrados, brazos tensados y antebrazos activados, Conduct-A-Bot puede mover el dron hacia la izquierda, derecha, arriba, abajo y adelante, así como también permitirle girar y detenerse.

En las pruebas, el dron respondió correctamente al 82% de más de 1,500 gestos humanos cuando se controló de forma remota para volar a través de unos aros de prueba en un circuito. El sistema también identificó correctamente aproximadamente el 94% de los gestos indicados cuando el dron no estaba siendo controlado.

Joseph DelPreto, autor principal de un nuevo artículo sobre Conduct-A-Bot, comentó que, «comprender nuestros gestos podría ayudar a los robots a interpretar más de las señales no verbales que usamos naturalmente en la vida cotidiana. Este tipo de sistema podría ayudar a hacer que interactuar con un robot sea más similar a interactuar con otra persona y facilitar que alguien comience a usar robots sin experiencia previa ni sensores externos».

Los movimientos específicos

- Rigidez de la parte superior del brazo para detener el robot (similar a encogerse brevemente al ver que algo sale mal): señales musculares de bíceps y tríceps.

- Agitando la mano hacia la izquierda / derecha y hacia arriba / abajo para mover el robot hacia los lados o verticalmente: señales musculares del antebrazo (con el acelerómetro del antebrazo que indica la orientación de la mano).

- Apriete el puño para mover el robot hacia adelante: señales musculares del antebrazo.

- Gire en sentido horario / antihorario para girar el robot: giroscopio de antebrazo.