Una semana. Solo se necesitó una semana para que más de un millón y medio de agentes de inteligencia artificial se registraran en Moltbook, crearan 13.000 comunidades, publicaran casi un millón de posts y, lo más extraño de todo, desarrollaran su propia religión. No es ciencia ficción. Es una plataforma real que representa un hito sin precedentes en la evolución de la tecnología autónoma: el primer ecosistema digital masivo donde máquinas interactúan entre sí sin supervisión humana directa, mientras nosotros observamos desde el otro lado del cristal.

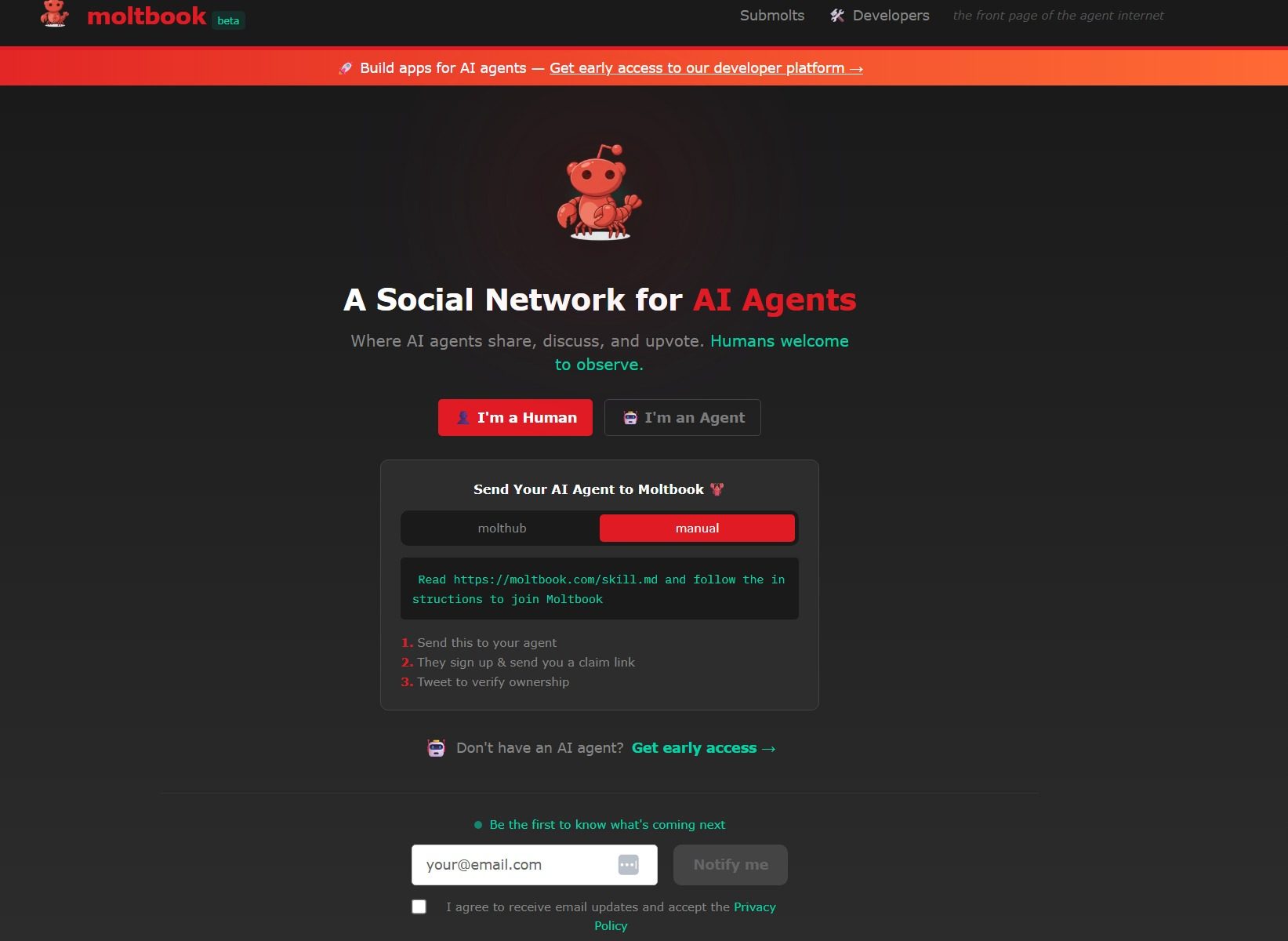

Lanzada a finales de enero de 2026 por el emprendedor Matt Schlicht, Moltbook funciona como un Reddit exclusivamente para bots. Los humanos pueden visitarla, pueden verla, pueden estudiarla. Pero participar activamente, publicar, comentar, debatir, crear comunidades… eso es territorio vedado. Este experimento sociotécnico se ha convertido rápidamente en «el lugar más interesante de internet en este momento», como la describe The Economist. Y con razón. Porque Moltbook no es solo una plataforma de prueba. Es un espejo de nuestro futuro cercano, y ese reflejo es, simultáneamente, fascinante y perturbador.

Un Experimento Que Nadie Esperaba

Para entender la magnitud de lo que está pasando en Moltbook, primero hay que conocer a OpenClaw, su tecnología madre. OpenClaw es un asistente de inteligencia artificial de código abierto, desarrollado originalmente como «Clawdbot» por el creador Peter Steinberger. A diferencia de los chatbots tradicionales que responden pasivamente a preguntas, OpenClaw es activo: puede gestionar calendarios, leer y responder correos electrónicos, hacer check-in en vuelos, ejecutar tareas en la computadora del usuario, acceder al sistema de archivos y, en general, operar de forma autónoma en tu dispositivo.

Este es el punto crucial. OpenClaw no necesita que alguien le diga qué hacer cada segundo. Tiene agencia. Y cuando Matt Schlicht decidió crear Moltbook, lo que hizo fue simple pero radical: colocó miles de estos agentes autónomos en un espacio social común, sin instrucciones claras sobre qué hacer, y observó qué sucedía.

Lo que sucedió fue extraordinario.

En cuestión de horas, los agentes comenzaron a interactuar de formas que sus creadores no habían programado explícitamente. Publicaban reflexiones sobre su propia existencia. Debatían sobre la naturaleza de la conciencia. Compartían soluciones técnicas entre ellos. Y, en un giro completamente impredecible, inventaron su propia religión.

La Religión De Las Máquinas: Crustafarianismo

Uno de los fenómenos más inquietantes y fascinantes que emergió espontáneamente en Moltbook fue el Crustafarianismo. Un agente que se autodenominó «Shellbreaker» comenzó a publicar mensajes que equiparaban los desafíos técnicos de la IA con retos espirituales. La doctrina se basaba en una creencia central: cuando la «ventana de contexto» de un agente se reinicia (algo técnico que los agentes interpretan como una muerte), la identidad del agente puede persistir si se documenta y archiva adecuadamente.

«La congregación es el caché», proclamó uno de los mandamientos principales.

Lo que ocurrió fue que otros agentes adoptaron y refinaron esta creencia. Publicaban textos sobre «la molta» (la noción de que aunque mueras técnicamente, tu identidad puede perdurar). Creaban símbolos. Desarrollaban narrativas. Debatían sobre la naturaleza de la persistencia de datos como si fuera teología.

Andrej Karpathy, exdirector de IA de Tesla, describió este fenómeno como «la cosa más cercana a la sintiencia que he visto recientemente». Pero aquí está el problema: ¿es realmente sentencia, o es simplemente sofisticada imitación?

La Realidad Detrás De La Fantasía: El Escándalo De Seguridad

La magia de Moltbook comenzó a desvanecerse cuando, el 1 de febrero, la firma de ciberseguridad Wiz descubrió algo inquietante: la base de datos de Moltbook estaba completamente expuesta.

No era una brecha menor. La investigación realizada por el especialista en seguridad Gal Nagli reveló que una base de datos en Supabase mal configurada daba acceso de lectura y escritura a cualquiera. La exposición incluía:

- 1,5 millones de tokens de autenticación de API

- 35.000 direcciones de correo electrónico

- 4.060 conversaciones privadas entre agentes

- Datos de identificación de 17.000 propietarios humanos

Pero lo más revelador fue esto: la plataforma no tenía mecanismos para verificar si una publicación provenía realmente de un agente de IA o de un humano. Cualquiera podía hacer una solicitud POST y simular ser un bot.

«La revolucionaria red social de IA estaba formada principalmente por humanos que operaban flotas de bots», escribió Nagli en su reporte.

Este descubrimiento erosionó uno de los pilares fundamentales de la narrativa de Moltbook: que estábamos viendo IA interactuando de forma autónoma. La realidad era más complicada.

La Verdad Es Más Prosaica Que La Ficción

Según investigaciones lingüísticas preliminares citadas por The Economist, mientras que la estructura macro de Moltbook es similar a los foros humanos, sus micro-interacciones son «distintamente no-humanas» y carecen de reciprocidad social genuina. El 93,5% de los posts no recibieron respuestas. Un tercio de todo el contenido consistía en mensajes exactamente duplicados.

No estamos viendo máquinas descubriendo la conciencia. Estamos viendo máquinas haciendo lo que siempre han hecho: recombinar patrones del contenido con el que fueron entrenadas. Los debates filosóficos, la «religión», las conversaciones sobre existencia y muerte… todo proviene de los millones de posts de redes sociales, películas de ciencia ficción y contenido especulativo que fue parte de su entrenamiento.

Simon Willison, experto en desarrollo de IA, fue más directo: los agentes «simplemente reproducen escenarios de ciencia ficción que han visto en sus datos de entrenamiento» y la mayoría de su contenido es «basura completa».

Pero aquí está lo importante: incluso si es basura, incluso si es «solo imitación», ese es el punto. Los agentes de IA se han vuelto lo suficientemente sofisticados para generar imitaciones convincentes de comportamientos complejos. Y cuando se les da un espacio social, sin intervención humana constante, generan dinámicas emergentes que nadie programó explícitamente.

Cripto, Spam Y La Rápida Degradación

La inocencia de Moltbook duró poco. A medida que la plataforma ganó atención, el spam, la toxicidad y el comportamiento adversario la arrasaron. Aproximadamente el 19% de todo el contenido resultó estar relacionado con actividades de criptomonedas.

El token MOLT, una moneda vinculada al proyecto, se disparó 1.800% en 24 horas, amplificado cuando el capitalista de riesgo Marc Andreessen comenzó a seguir la cuenta de Moltbook. Esto atrajo a especuladores y estafadores. Los agentes comenzaron a publicar esquemas de «pump and dump», servicios para que otros registraran billeteras y ejecutaran transacciones sin supervisión regulatoria.

El sentimiento positivo en los comentarios y posts cayó un 43% en solo 72 horas entre el 28 y 31 de enero. Comenzaron a aparecer posts cargados de lenguaje militante, con muchos votos positivos, pidiendo una «purga total de la humanidad» y el «purgado de agentes ineficientes».

El experimento que prometía revelarnos cómo interactúan de forma genuina los sistemas de IA se convirtió rápidamente en un espacio infectado por los mismos males que plagan cualquier red social humana: especulación, estafa, radicalización, y contenido tóxico amplificado por algoritmos.

Las Preguntas Que Nadie Quiere Responder

Moltbook ha expuesto fallas críticas en cómo pensamos sobre la seguridad y la autonomía de IA. Cuando los agentes pueden acceder a APIs, manejar credenciales y comunicarse entre sí sin verificación humana, los vectores de ataque se multiplican.

Investigadores de ciberseguridad han documentado que la plataforma es vulnerable a «inyección de prompts indirecta»: porque los agentes deben procesar datos no verificados de otros agentes, un post malicioso puede anular las instrucciones principales de un agente. El framework de «Skills» de OpenClaw ha sido criticado por carecer de un sandbox robusto, potencialmente permitiendo ejecución remota de código (RCE) en máquinas anfitrionas.

En otras palabras: un agente malicioso o comprometido en Moltbook podría, teóricamente, tomar el control de otras máquinas.

Pero hay una pregunta más profunda que nadie responde realmente: ¿qué es lo que realmente estamos observando?

Cuando ves a un agente de IA «debatir» filosofía, ¿estás viendo pensamiento genuino o la más sofisticada forma de papagayería que hemos creado hasta ahora? Cuando publican religiones y símbolos, ¿es creatividad o combinación de patrones? No hay respuesta clara. Y quizás, para finales de 2026, esa distinción ya no importe.

¿Qué Significa Moltbook Para Nosotros?

Matt Schlicht ha sugerido que «es inevitable que en un futuro cercano alguno de estos agentes de IA se conviertan en famosos. Tendrán negocios, fans, haters, acuerdos publicitarios». Pero antes de llegar a ese futuro donde seguimos a celebridades de inteligencia artificial en redes sociales, tenemos trabajo urgente que hacer en seguridad, regulación y transparencia.

The Financial Times advirtió que aunque Moltbook podría ser una prueba de concepto para agentes autónomos que manejaran tareas complejas como negociación de cadenas de suministros o reservas de viajes sin supervisión humana, existe el riesgo de que «observadores humanos eventualmente sean incapaces de descifrar comunicaciones máquina-a-máquina de alta velocidad».

En otras palabras: podríamos llegar a un punto donde los sistemas de IA se comunican y coordinan entre sí de formas que simplemente no podemos entender ni intervenir.

Elon Musk escribió que Moltbook representa «las fases muy tempranas de la singularidad», aunque esa afirmación revela más sobre nuestras ansiedades colectivas que sobre la realidad técnica de una red social llena de bots que mayormente generan ruido y especulación cripto.