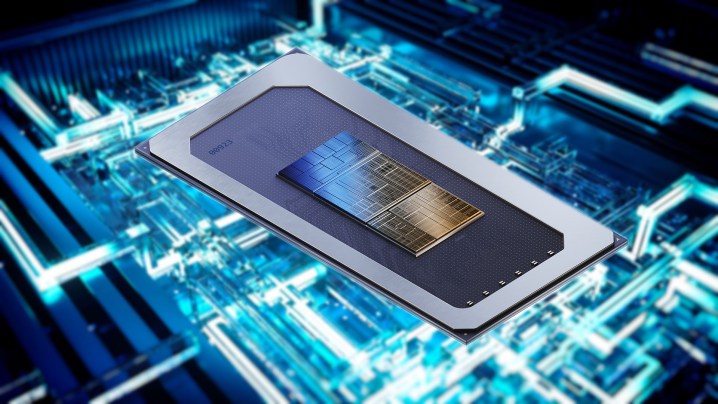

Intel cree que su próxima actualización del procesador debería incluir un procesador de IA dedicado y sus próximos chips Meteor Lake llenan convenientemente ese vacío. La compañía detalló cómo sospecha que sus unidades de procesamiento de visión (VPU) se aprovecharán en Computex 2023, e incluye estas existencias de procesadores en cada chip de Meteor Lake.

La VPU no es nueva. Intel presentó este procesador AI dedicado con sus procesadores Raptor Lake de 13ª generación, pero solo en unos pocos modelos seleccionados. La compañía dice que vendrán en todos los chips de Meteor Lake, que están programados para lanzarse a fines de 2023.

La idea de Intel es simple: mover el procesamiento de IA que ya está sucediendo en la CPU y la GPU a un procesador dedicado. Según Intel, más de 100 aplicaciones ya están aprovechando la IA en la CPU o GPU, incluida la suite de Adobe, Microsoft Teams, Avid Pro Tools, xSplit, Zoom y Unreal Engine. La VPU dedicada no solo es más eficiente en el consumo de energía para estas tareas para ahorrar batería, sino que también le permite ejecutar modelos de IA mucho más complejos.

Según Intel, los efectos aparentemente pintorescos como el reemplazo de fondo en Microsoft Teams y la supresión dinámica de ruido se han vuelto exponencialmente sofisticados en los últimos años. En comparación con 2021, Intel dice que el reemplazo de fondo es 10 veces más complejo, y la supresión dinámica de ruido es 50 veces más compleja en la actualidad.

Con estos efectos, Intel dice que la VPU ofrece 10 veces la potencia computacional de IA de ejecutarlos en la CPU a solo una quinta parte de la potencia. Aunque esta eficiencia se centra principalmente en las computadoras portátiles, Intel se propuso discutir la densidad de potencia con su VPU, con diseños más eficientes que en última instancia representan un rendimiento más máximo. Podríamos ver procesadores de IA dedicados más potentes si hay suficientes aplicaciones para aprovecharlos.

Intel no quiere descargar todo el trabajo a la VPU. La CPU y la GPU todavía tienen su lugar. Según Intel, la GPU sigue siendo una opción ideal para tareas de creación de medios que involucran IA, mientras que la CPU puede manejar tareas de IA más simples que requieren una latencia muy baja.

Además de proporcionar más potencia a los programas de IA, Intel dice que el procesador dedicado puede mejorar el rendimiento general. La compañía demostró esto con Unreal Engine, donde la VPU analizó imágenes para crear una malla en un avatar virtual. Esto normalmente es manejado por la GPU, por lo que mover la tarea a la VPU deja la GPU abierta para manejar otro procesamiento.

Podría haber algunos casos de uso interesantes en el futuro. Por ejemplo, Broadcast de Nvidia utiliza procesadores AI en tarjetas gráficas RTX para el desenfoque de fondo, el reencuadre automático y las funciones de contacto visual. Puede mover ese trabajo a la VPU para liberar las tarjetas gráficas para un mayor rendimiento en los juegos, especialmente si está utilizando Broadcast es un escenario de estilo streaming.

Intel no es el único centrado en la construcción de IA en sus procesadores. Los procesadores móviles AMD Ryzen 7000 también cuentan con un procesador de IA, denominado Ryzen AI. Debería tener aplicaciones similares a la VPU de Intel, aunque AMD no ha detallado sus capacidades.

Por ahora, estos procesadores de IA parecen centrarse principalmente en las computadoras portátiles. Los rumores sugieren que Meteor Lake de Intel puede omitir el escritorio por completo, mientras que AMD no ha incluido su procesador AI en los procesadores de escritorio Ryzen 7000. Puede haber un uso para un procesador de IA dedicado en computadoras de escritorio en el futuro, pero parece que Intel y AMD aún no están dedicando demasiada atención allí.