Uno podría pensar que una GPU que cuesta más de $ 40,000 será la mejor tarjeta gráfica para juegos, pero la verdad es mucho más compleja que eso. De hecho, esta GPU Nvidia ni siquiera puede mantenerse al día con las soluciones gráficas integradas.

Ahora, antes de que te enojes demasiado, debes saber que me refiero al H100 de Nvidia, que alberga el chip GH100 (Grace Hopper). Es una potente GPU de centro de datos hecha para manejar tareas de computación de alto rendimiento (HPC), no para alimentar juegos de PC. No tiene ninguna salida de pantalla, y a pesar de sus amplias capacidades, tampoco tiene refrigeradores. Esto se debe a que, nuevamente, encontraría esta GPU en un centro de datos o en un entorno de servidor, donde se enfriaría con potentes ventiladores externos.

Si bien «solo» tiene 14,592 núcleos CUDA (que es menos que el RTX 4090), también tiene una cantidad insana de VRAM y un bus masivo. En total, la GPU tiene 80 GB de memoria HBM2e, dividida en cinco pilas HBM, cada una conectada a un bus de 1024 bits. A diferencia de las GPU de consumo de Nvidia, esta tarjeta también tiene NVLink, lo que significa que se puede conectar para funcionar sin problemas en sistemas multi-GPU.

La pregunta sigue siendo: ¿Por qué exactamente este tipo de GPU es tan malo en el uso general y los juegos?

Para demostrar el caso, YouTuber Gamerwan recibió cuatro de estas tarjetas gráficas H100 para probar, y decidió poner una en un sistema Windows normal para verificar su rendimiento. Este era un modelo PCIe 5.0, y tuvo que ser emparejado con una RTX 4090 debido a la falta de salidas de pantalla. Gamerwan también imprimió en 3D un refrigerador externo diseñado a medida para mantener la GPU funcionando sin problemas.

Se necesita un poco de trabajo incluso para que el sistema reconozca el H100 como una GPU adecuada, pero una vez que Gamerwan logró superar los obstáculos, también pudo activar el soporte de trazado de rayos. Sin embargo, como descubrimos más tarde a lo largo de las pruebas, no hay mucho soporte para nada más en una plataforma que no sea de centro de datos.

En una prueba estándar de 3DMark Time Spy, la GPU solo alcanzó los 2.681 puntos. A modo de comparación, el puntaje promedio para el RTX 4090 es de 30,353 puntos. Esta puntuación coloca a la H100 en algún lugar entre la GTX 1050 de consumo y la GTX 1060. Más importante aún, es casi lo mismo que la Radeon 680M de AMD, que es una GPU integrada.

Las pruebas de juego también fueron mal, con la tarjeta gráfica alcanzando un promedio de 8 cuadros por segundo (fps) en Red Dead Redemption 2. La falta de soporte de software asoma su fea cabeza aquí: aunque el H100 puede funcionar a un máximo de 350 vatios, el sistema parece no poder superarlo de 100W, lo que resulta en un rendimiento enormemente limitado.

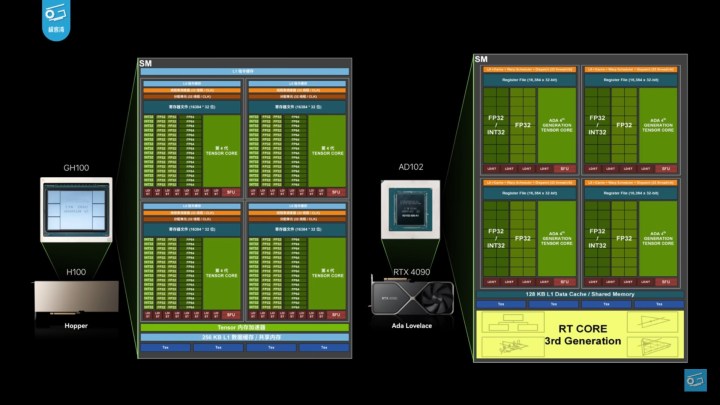

Hay algunas razones diferentes para esta pobre muestra de poderes de juego. Por un lado, aunque la H100 es una tarjeta gráfica ultra fuerte en papel, es muy diferente a nivel arquitectónico que la GPU AD102 que alimenta la RTX 4090. Solo tiene 24 unidades operativas ráster (ROP), lo que es una degradación significativa de los 160 ROP que tiene la RTX 4090. Además, solo cuatro de los 112 clústeres de procesamiento de texturas (TPC) pueden representar cargas de trabajo de gráficos.

Las GPU de consumo de Nvidia reciben mucho soporte en el lado del software para funcionar bien. Esto incluye controladores, pero también soporte de sistemas de desarrolladores, tanto en juegos como en programas de referencia. No hay controladores que optimicen el rendimiento de esta GPU para el juego, y el resultado es, como puede ver, extremadamente pobre.

Ya hemos visto el poder de los controladores con Intel Arc, donde el hardware se ha mantenido igual, pero el soporte mejorado del controlador brindó ganancias de rendimiento que hicieron de Arc una opción aceptable si está comprando una GPU económica. Sin controladores Nvidia Game Ready y sin acceso al resto de la pila de software de Nvidia (incluido el siempre impresionante DLSS 3), el H100 es una GPU de $ 40,000 que no tiene por qué ejecutar ningún tipo de juego.

En esencia, esta es una GPU informática, y no una tarjeta gráfica de la misma manera que la mayoría de nosotros las conocemos. Fue hecho para todo tipo de tareas de HPC, con un fuerte enfoque en las cargas de trabajo de IA. Nvidia mantiene una fuerte ventaja sobre AMD en lo que respecta a la IA, y tarjetas como la H100 juegan un papel importante en eso.