Una nueva técnica clave permitirá ahora saber cuándo un rostro podría o no ser deepfake, es decir, manipulado con algún tipo de IA generativa.

Y lo sorprendente es que se hace utilizando las mismas técnicas que utilizan los astrónomos para analizar las observaciones de las galaxias.

Una nueva investigación compartida en la Reunión Nacional de Astronomía de la Royal Astronomical Society en Hull, sugiere que las falsificaciones generadas por IA se pueden detectar analizando los ojos humanos de la misma manera que los astrónomos estudian las imágenes de las galaxias.

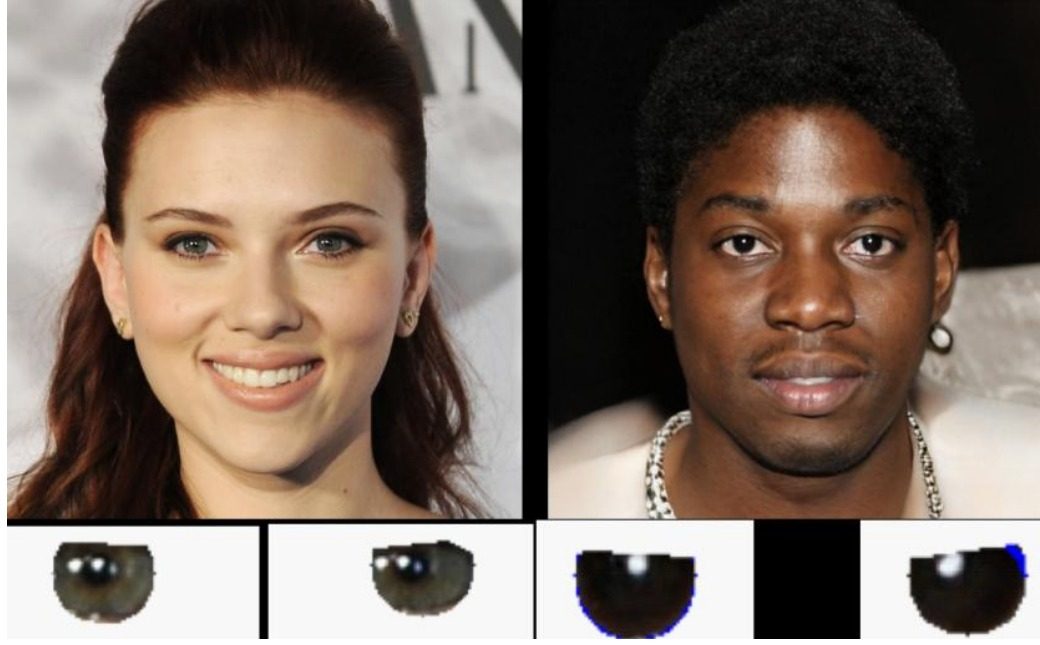

Un equipo dirigido por el estudiante de maestría de la Universidad de Hull, Adejumoke Owolabi, descubrió que los reflejos de luz en los ojos de los humanos deepfaked simplemente no se alinean.

«Los reflejos en los globos oculares son consistentes para la persona real, pero incorrectos (desde el punto de vista de la física) para la persona falsa», dijo el profesor de astrofísica de la Universidad de Hull, Kevin Pimbblet, en un comunicado.

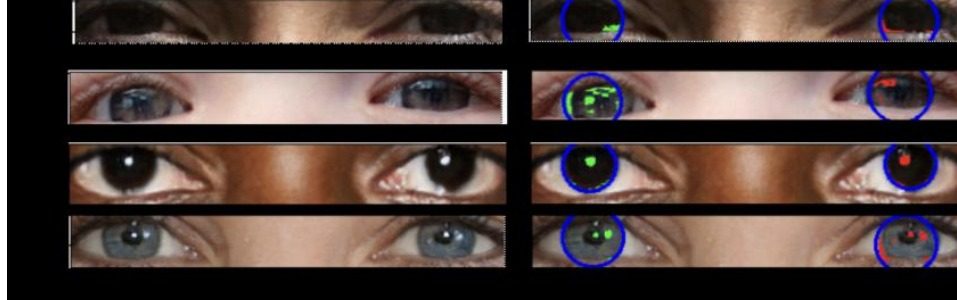

Los investigadores analizaron los reflejos de la luz en los globos oculares de las personas en imágenes reales y generadas por IA. A continuación, emplearon métodos normalmente utilizados en astronomía para cuantificar los reflejos y comprobaron la coherencia entre los reflejos del globo ocular izquierdo y derecho.

Las imágenes falsas a menudo carecen de consistencia en los reflejos entre cada ojo, mientras que las imágenes reales generalmente muestran los mismos reflejos en ambos ojos.

«Para medir las formas de las galaxias, analizamos si son centralmente compactas, si son simétricas y qué tan suaves son. Analizamos la distribución de la luz», dijo el profesor Pimbblet.

«Detectamos los reflejos de forma automatizada y analizamos sus características morfológicas a través de los índices CAS [concentración, asimetría, suavidad] y Gini para comparar la similitud entre los globos oculares izquierdo y derecho.

El coeficiente de Gini mide la distribución de la luz en cualquier imagen dada de una galaxia. Ordena los píxeles por su brillo y compara los resultados con una distribución perfectamente uniforme.

«Es importante tener en cuenta que esto no es una bala de plata para detectar imágenes falsas», agregó el profesor Pimbblet. «Hay falsos positivos y falsos negativos; No lo va a conseguir todo. Pero este método nos proporciona una base, un plan de ataque, en la carrera armamentística para detectar deepfakes».