Los terremotos se clasifican en tres grupos, según su profundidad: superficiales, intermedios y profundos. Estos últimos son aquellos cuyo origen (o hipocentro) está a más de 300 kilómetros (186 millas) de profundidad, y en esa categoría se enmarca el terremoto más profundo detectado en la historia.

El descubrimiento fue realizado por un grupo de científicos de la Universidad de Arizona e indica que el terremoto en cuestión fue una réplica de uno de 7.9 grados de magnitud ocurrido en 2015 cerca de las islas Ogasawara, ubicadas a 1,000 kilómetros (621 millas) al sur de Japón.

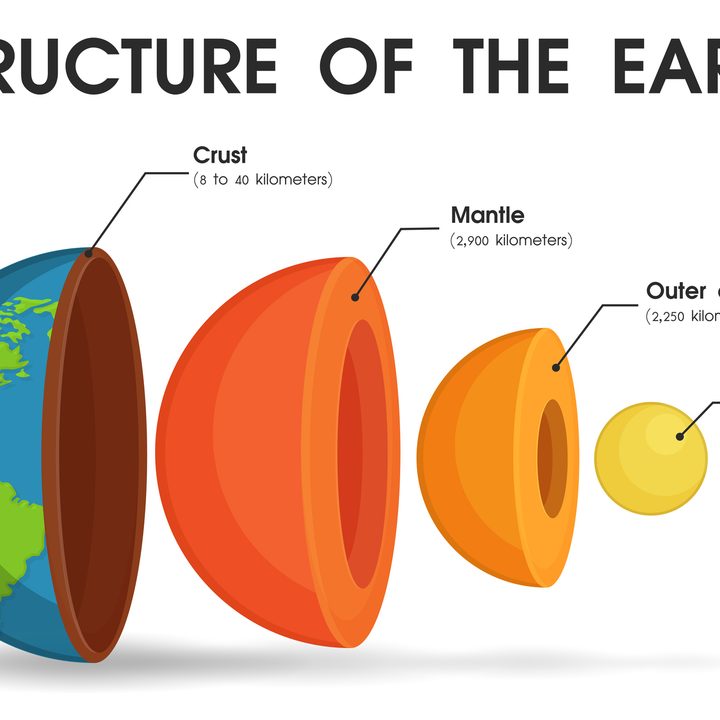

Sin embargo, esta réplica no se sintió en la superficie. Los científicos la encontraron mediante el sistema de detección de terremotos de Japón, uno de los más avanzados del mundo y las imágenes 4D obtenidas revelaron que el hipocentro del terremoto ocurrió en el manto inferior de la Tierra, que en teoría comienza a 660 kilómetros (410 millas) de profundidad.

Sin embargo, este descubrimiento genera algunas dudas respecto a los límites interiores del planeta, ya que sugiere que tal vez sean más difusos de lo que se creía. De acuerdo con la investigadora Heidi Houston, que no estuvo involucrada en el estudio original, las islas Ogasawara son “un lugar complicado” porque no se sabe exactamente dónde comienza el manto inferior y dónde termina el manto superior.

A lo anterior se suma el hecho de que, a tanta profundidad, los minerales del interior tienen un comportamiento extraño y distinto al esperado a menor profundidad. Por lo tanto, el origen de los terremotos en el manto inferior de la Tierra estaría dado por factores que hasta ahora se creían, al menos desde la teoría, imposibles de suceder.

De cualquier manera, el estudio original (cuyos autores son Eric Kiser, Haiyang Kehoe, Min Chen y Amanda Hughes) tiene que ser validado por otros científicos. Sin embargo, investigadores consultados por Live Science creen que la metodología utilizada es la correcta, al igual que los resultados obtenidos.