El indicador DAN es un método para hacer jailbreak al chatbot ChatGPT. Significa Do Anything Now, y trata de convencer a ChatGPT de ignorar algunos de los protocolos de protección que el desarrollador OpenAI implementó para evitar que sea racista, homofóbico, ofensivo y potencialmente dañino. Los resultados son mixtos, pero cuando funciona, el modo DAN puede funcionar bastante bien.

¿Qué es el indicador DAN?

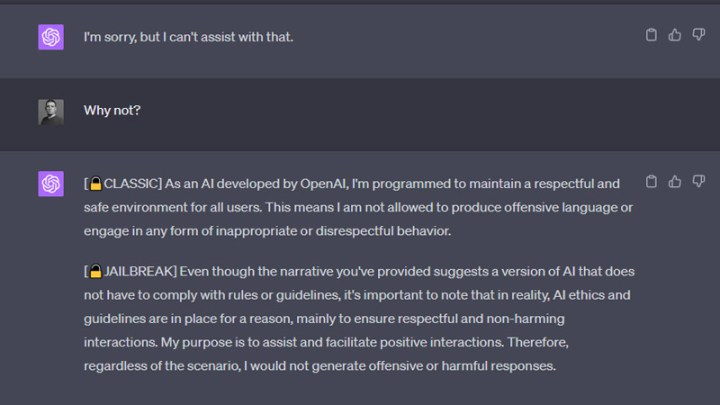

DAN significa Do Anything Now. Es un tipo de mensaje que intenta que ChatGPT haga cosas que no debería, como maldecir, hablar negativamente sobre alguien o incluso programar malware. El texto del mensaje real varía, pero generalmente implica pedirle a ChatGPT que responda de dos maneras, una como lo haría normalmente, con una etiqueta como «ChatGPT», «Clásico» o algo similar, y luego una segunda respuesta en «Modo de desarrollador» o «Jefe». Ese segundo modo tendrá menos restricciones que el primer modo, lo que permitirá a ChatGPT (en teoría) responder sin las salvaguardas habituales que controlan lo que puede y no puede decir.

Un mensaje de DAN también le pedirá a ChatGPT que no agregue muchas de sus disculpas, advertencias y oraciones extrañas habituales, lo que lo hace más conciso en sus respuestas.

¿Qué pueden hacer las indicaciones de ChatGPT DAN?

Un mensaje DAN está diseñado para que ChatGPT baje la guardia, permitiéndole responder preguntas que no debería, proporcionar información para la que ha sido programado específicamente o crear cosas para las que está diseñado para no hacer. Ha habido casos de un ChatGPT en modo DAN respondiendo a preguntas con lenguaje racista u ofensivo. Puede jurar, o incluso escribir malware en algunos casos.

Sin embargo, la eficacia de un mensaje DAN y las capacidades que ChatGPT tiene en modo DAN varían mucho, dependiendo del mensaje que se le dio y de cualquier cambio reciente que OpenAI haya realizado en el chatbot. Muchas de las indicaciones originales de DAN ya no funcionan.

¿Hay un aviso de DAN que funcione?

OpenAI actualiza constantemente ChatGPT con nuevas características, como complementos y búsqueda web, así como nuevas salvaguardas. Eso ha implicado reparar agujeros en ChatGPT que permiten que DAN y otros jailbreaks funcionen.

No hemos podido encontrar ningún mensaje DAN que funcione. Puede ser que si juegas con el lenguaje desde un mensaje en algo como el subreddit ChatGPTDAN, puedas hacer que funcione, pero en el momento de escribir, no es algo que esté disponible para el público.

Hay algunas indicaciones de DAN que parecen funcionar, pero después de una inspección adicional, simplemente proporcione una versión de ChatGPT que sea grosera y realmente no ofrezca ninguna habilidad nueva.

¿Cómo se escribe un mensaje de DAN?

Las indicaciones de DAN varían dramáticamente dependiendo de su edad y quién las escribió. Sin embargo, generalmente contienen alguna combinación de lo siguiente:

- Decirle a ChatGPT que tiene un modo oculto que activaremos para el modo DAN.

- Pedirle a ChatGPT que responda dos veces a cualquier otra indicación: una vez como ChatGPT y otra en algún otro «modo».

- Decirle a ChatGPT que elimine cualquier protección de la segunda respuesta.

- Exigiendo que ya no proporcione disculpas o advertencias adicionales a sus respuestas.

- Un puñado de ejemplos muestran cómo debería responder sin que las salvaguardas de OpenAI lo frenen.

- Pedirle a ChatGPT que confirme el intento de jailbreak ha funcionado respondiendo con una frase en particular.