Cuando pensamos en las mejores tarjetas gráficas de hoy en día, nos vienen a la mente GPU como la RTX 4090 o la RX 7900 XTX. Sin embargo, para que estas tarjetas bestiales pudieran funcionar, algunas GPU mucho más antiguas tuvieron que gatear, y luego caminar, para llevarnos a donde estamos hoy.

Mirando hacia atrás, la historia de las tarjetas gráficas nos muestra algunos hitos que redefinieron la tecnología gráfica. Hagamos un viaje a 1996 y años posteriores para explorar las tarjetas gráficas que marcaron la diferencia, tuvieron un impacto y fueron grandes éxitos entre los entusiastas de todo el mundo.

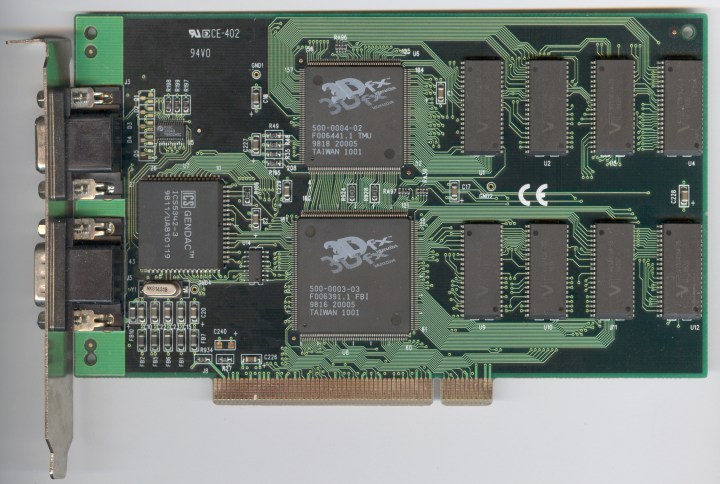

Vudú 3dfx

El 3dfx Voodoo marca el amanecer de la aceleración de gráficos 3D de consumo. Este acelerador de gráficos, equipado con una modesta velocidad de reloj de 50 MHz y 4/6 MB de memoria, por no hablar de un nodo de proceso de 500 nm, puede no parecer mucho. Sin embargo, abrió los juegos a un mercado completamente nuevo cuando se lanzó en 1996.

ATI Radeon 9700 Pro

Solo unos años más tarde, en 2002, la Radeon 9700 Pro de ATI fue el rey de los gráficos durante un tiempo, y ciertamente tenía especificaciones mucho mejores que la 3dfx Voodoo. Basado en un nodo de proceso de 150 nm, tenía un reloj central de 325 MHz y 128 MB de memoria DDR a través de una interfaz de 256 bits. Podría soportar resoluciones de hasta 2.048 x 1.536.

Y lo que es más importante, fue la primera tarjeta gráfica compatible con DirectX 9.0, pero eso no es todo. Esta es la GPU que popularizó el antialiasing (AA) y el filtrado anisotrópico (AF). Antes de esta tarjeta, esas características no eran realmente convencionales, pero esta GPU lo hizo posible. También superó a sus competidores, como la GeForce4 Ti 4600 de Nvidia, hasta en un 100% con AA y AF habilitados.

La adopción temprana de DirectX 9 por parte de ATI le permitió destacarse en comparación con la serie GeForce4 Ti de Nvidia, que no ofrecía soporte de hardware para DX9. Este fue un período de tiempo en el que ATI, más tarde AMD, dominó a Nvidia como nunca antes, lanzando una generación de tarjetas gráficas que derrotaron a Nvidia con facilidad. A la Radeon 9700 Pro le siguió la Radeon 9800 Pro, que también fue un gran éxito tanto entre los jugadores como entre los críticos.

ATI continuó intercambiando golpes con Nvidia durante unos años más, hasta que fue adquirida por AMD en 2006. La marca ATI se extinguió en 2010, pero Radeon aún permanece en los nombres de las tarjetas gráficas de AMD.

Nvidia GeForce 8800 GTX

Vamos a 2006, cuando la batalla entre Nvidia y ATI (más tarde AMD) estaba en su apogeo. Fue entonces cuando Nvidia lanzó la GeForce 8800 GTX, una tarjeta gráfica masiva (en ese momento) que encabezó una arquitectura de GPU clave que todavía se usa hasta el día de hoy. Lanzada como parte de dos buques insignia de la serie GeForce 8, la 8800 GTX era una GPU de nivel entusiasta con algunas capacidades de juego feroces.

Toda la línea fue bastante excepcional para su época, pero la 8800 GTX es recordada como un buque insignia monstruoso con algunas especificaciones bastante intensas. Tenía una velocidad de reloj de 575 MHz y contaba con 768 MB de VRAM GDDR3 a través de un bus de memoria de 384 bits. Podía manejar resoluciones de hasta 2.560 x 1.600. Y lo que es más importante, introdujo texturas de sombreado unificadas, impulsando a la GPU a una nueva era de capacidades gráficas con un rendimiento sin precedentes para la época.

Antes de la serie GeForce 8, las tarjetas gráficas usaban sombreadores separados para diferentes tipos de procesamiento, como sombreadores de vértices y píxeles. La arquitectura unificada, que todavía se usa en las GPU modernas, los combinó en una sola canalización más flexible. Esto abrió los recursos de la GPU e hizo que el procesamiento fuera más eficiente.

Además, la 8800 GTX fue la primera en usar DirectX 10, y eso fue una gran mejora en comparación con la versión anterior. Con todo, fue un éxito en su lanzamiento, y se mantuvo durante años, incluso cuando las GPU más nuevas llegaron al mercado.

AMD Radeon R9 290

Cuando AMD lanzó la Radeon R9 290 en 2013, el panorama gráfico ya era muy diferente al que veíamos a finales de la década de 1990 y principios de la de 2000. Presentaba una velocidad de reloj de hasta 947 MHz y 4 GB de memoria GDDR5 a través de un bus de 512 bits. A modo de comparación, Nvidia tiene una versión de la RTX 3050 que también cuenta con 4 GB de VRAM (y una interfaz de 128 bits), aunque se trata de GDDR6. La R9 290 también podría manejar resoluciones de hasta 4K, por lo que está mucho más cerca de las mejores GPU que estamos viendo en estos días que cualquiera de las tarjetas anteriores de esta lista.

Gracias a la espaciosa interfaz de memoria de 512 bits, el R9 290 podía proporcionar un gran ancho de banda de memoria, y eso desbloqueaba juegos de alta gama. También era compatible con la API Mantle de AMD, que fue un intento temprano de crear una API de gráficos de bajo nivel que más tarde influyó en el desarrollo de Vulkan. Algunos también afirman que DirectX 12 también fue influenciado por Mantle de alguna manera. La Radeon R9 290 también fue una de las primeras veces que vimos hardware de procesamiento de audio dedicado en el lado de la GPU.

El legado del AMD R9 290 radica no solo en las nuevas características, sino en el nacimiento del enfoque de rendimiento por dólar de AMD. Era una tarjeta gráfica capaz de ofrecer un rendimiento de gama alta a un precio mucho más asequible (400 dólares) de lo que los entusiastas estaban acostumbrados en ese momento. La R9 290 pudo ofrecer el 106% del rendimiento que ofrece la Nvidia GeForce GTX 780, y a $ 100 menos. No olvidemos que era casi tan potente como el R9 290X, siendo 150 dólares más barato.

El mercado de GPU para juegos de gama alta nunca fue barato, aunque en estos días es más caro que nunca. Pero con la R9 290, AMD mostró a las masas que es completamente posible hacer una GPU premium y ponerle un precio de una manera que hizo que Nvidia se apresurara a ofrecer descuentos. Tengamos más de eso en 2024, por favor.

Nvidia GeForce GTX 1080 Ti

Ah, la GTX 1080 Ti, la guinda de la excelente arquitectura Pascal de Nvidia. Toda esa generación de GPU envejeció tan bien que todavía ocupan un lugar destacado en la encuesta mensual de hardware de Steam, y personalmente solo me deshice de mi GTX 1060 hace solo unos meses. Y sí, juego juegos AAA.

El buque insignia de Nvidia, lanzado en 2017, venía con un reloj máximo de 1.582 MHz y una enorme memoria (en ese momento, e incluso hoy) de 11 GB de memoria GDDR5X a través de un bus de 352 bits. Con 3.584 núcleos CUDA y soporte para una resolución de hasta 8K, esta GPU sigue resistiendo bien hasta el día de hoy, superando fácilmente a las tarjetas gráficas económicas más antiguas.

Hasta el día de hoy, creo que la GTX 1080 Ti fue uno de los mayores logros de Nvidia. Con solo 250 vatios, la GPU limpió el piso con el Titan X Pascal. Eso no es todo: cuando Nvidia lanzó la Titan Xp algún tiempo después, era solo un pequeño porcentaje más rápida que la GTX 1080 Ti. A $ 1,200 para el Titan y $ 700 para el 1080 Ti, era una elección obvia en cuanto a qué tarjeta elegir.

En su apogeo, la GTX 1080 Ti era el objetivo de todo jugador, y usar dos de ellas a través del SLI de Nvidia era el sueño en el que algunos entusiastas derrochabon. Si bien SLI está prácticamente muerta ahora, y usar dos GPU 1080 Ti nunca valió la pena, la tarjeta fue una potencia que redefinió la idea de los juegos de alta gama. Ojalá pudiéramos obtener ese tipo de rendimiento relativo por solo $ 700 en estos días. Por supuesto, los 700 dólares dolieron más en 2017, cuando las GPU eran generalmente más baratas.

Nvidia GeForce RTX 3060 Ti

La RTX 3060 Ti de Nvidia ya no es una de las mejores tarjetas gráficas. Ha sido reemplazada en gran medida por la serie RTX 40 o, en el lado económico, por la serie RX 7000 de AMD. Sin embargo, es una GPU tan buena que la recomendaría por encima de muchas ofertas de la generación actual, siempre que puedas encontrar una buena oferta en ella.

La RTX 3060 Ti es una de las primeras tarjetas que ofrecía un rendimiento razonable de trazado de rayos a un precio convencional. Con un precio de 400 dólares en el momento del lanzamiento, la GPU tiene una velocidad de reloj máxima de 1.665 MHz, 8 GB de memoria GDDR6, un bus de 256 bits y 4.864 núcleos CUDA. En comparación con la decepcionante RTX 4060 Ti, la RTX 3060 Ti es a veces más rápida que su sucesora, e incluso cuando no lo es, sigue el ritmo. Teniendo en cuenta que la RTX 4060 Ti llegó dos años y medio después, dice mucho sobre el potencial y las capacidades de la RTX 3060 Ti.

Este fue también uno de los primeros lanzamientos de GPU en los que la actualización de la GTX 1080 Ti tenía sentido. Es un testimonio del poder de Pascal que la RTX 3060 Ti es solo un 15% más rápida que la 1080 Ti, pero ofrece acceso a toda la pila de software RTX de Nvidia, incluido el siempre impresionante DLSS.

El impacto de la RTX 3060 Ti puede parecer menor ahora que sabemos que Nvidia introdujo más tarde DLSS 3, disponible sólo en las tarjetas de la serie RTX 40, que aplastó a DLSS 2. Sin embargo, aunque la RTX 3060 Ti no introdujo ninguna característica destacada por sí sola, fue una GPU histórica para su generación, que ofrecía acceso a juegos AAA con un presupuesto ajustado en una época en la que la escasez de GPU asolaba todo el mercado. Hasta el día de hoy, es la quinta tarjeta gráfica más popular en la encuesta de hardware de Steam, y sigue siendo una opción que tiene sentido comprar para una PC económica. Eso es mucho decir para una GPU que se lanzó a finales de 2020.