OpenAI está implementando nuevas funcionalidades para ChatGPT que permitirán que las indicaciones se ejecuten con imágenes y directivas de voz además de texto.

La marca AI anunció el lunes que pondrá estas nuevas características a disposición de los usuarios de ChatGPT Plus y Enterprise durante las próximas dos semanas. La función de voz está disponible en iOS y Android en una capacidad opcional, mientras que la función de imágenes está disponible en todas las plataformas ChatGPT. OpenAI señala que planea expandir la disponibilidad de las imágenes y las funciones de voz más allá de los usuarios pagos después del lanzamiento escalonado.

El chat de voz funciona como una conversación auditiva entre el usuario y ChatGPT. Presionas el botón y dices tu pregunta. Después de procesar la información, el chatbot le da una respuesta en el habla auditiva en lugar de en el texto. El proceso es similar al uso de asistentes virtuales como Alexa o Google Assistant y podría ser el preámbulo de una renovación completa de los asistentes virtuales en su conjunto. El anuncio de OpenAI se produce pocos días después de que Amazon revelara una característica similar que llegará a Alexa.

Para implementar la comunicación de voz y audio con ChatGPT, OpenAI utiliza un nuevo modelo de texto a voz que puede generar «audio similar al humano a partir de solo texto y unos segundos de habla de muestra». Además, su modelo Whisper puede «transcribir sus palabras habladas en texto».

OpenAI dice que es consciente de los problemas que podrían surgir debido al poder detrás de esta característica, incluido «el potencial de que los actores maliciosos se hagan pasar por figuras públicas o cometan fraude».

Esta es una de las principales razones por las que la compañía planea limitar el uso de sus nuevas características a «casos de uso y asociaciones específicos». Incluso cuando las características estén más ampliamente disponibles, serán accesibles principalmente para usuarios más privilegiados, como los desarrolladores.

ChatGPT can now see, hear, and speak. Rolling out over next two weeks, Plus users will be able to have voice conversations with ChatGPT (iOS & Android) and to include images in conversations (all platforms). https://t.co/uNZjgbR5Bm pic.twitter.com/paG0hMshXb

— OpenAI (@OpenAI) September 25, 2023

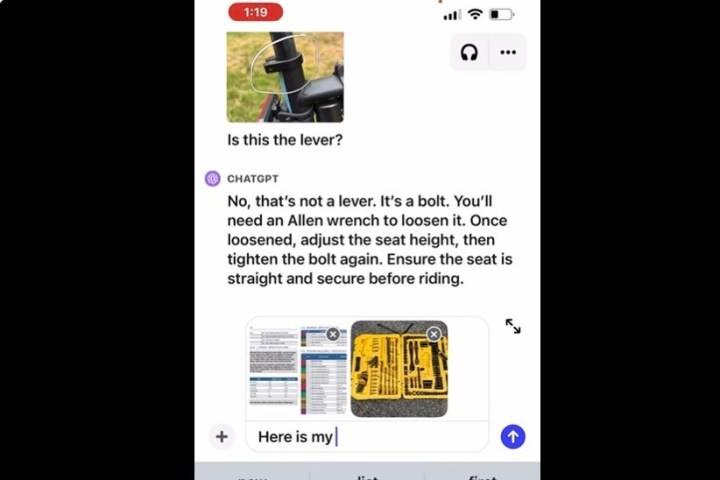

La función de imagen le permite capturar una imagen e ingresarla en ChatGPT con su pregunta o aviso. Puede usar la herramienta de dibujo con la aplicación para ayudar a aclarar su respuesta y tener una conversación de ida y vuelta con el chatbot hasta que se resuelva su problema. Esto es similar a la nueva función Copilot de Microsoft en Windows, que se basa en el modelo de OpenAI.

OpenAI también ha reconocido los desafíos de ChatGPT, como su problema de alucinación en curso. Cuando se alineó con la función de imagen, la marca decidió limitar ciertas funcionalidades, como la «capacidad del chatbot para analizar y hacer declaraciones directas sobre las personas».

ChatGPT se introdujo por primera vez como una herramienta de texto a voz a fines del año pasado; sin embargo, OpenAI ha expandido rápidamente su destreza. El chatbot original basado en el modelo de lenguaje GPT-3 se ha actualizado a GPT-3.5 y ahora GPT-4, que es el modelo que recibe la nueva característica.

Cuando GPT-4 se lanzó por primera vez en marzo, OpenAI anunció varias colaboraciones empresariales, como Duolingo, que utilizó el modelo de IA para mejorar la precisión de las lecciones basadas en la escucha y el habla en la aplicación de aprendizaje de idiomas. OpenAI ha colaborado con Spotify para traducir podcasts a otros idiomas mientras preserva el sonido de la voz del podcaster. La compañía también habló de su trabajo con la aplicación móvil, Be My Eyes, que trabaja para ayudar a las personas ciegas y con baja visión. Muchas de estas aplicaciones y servicios estaban disponibles antes de la actualización de imágenes y voz.