Hace tres años conocimos Google Photos, un hogar ideal para poner todas nuestras fotos y videos. Hoy, en el marco del congreso anual de desarrolladores Google I/O, hemos podido conocer algunas nuevas maneras de aprovechar y sacarle más partido a esta excelente herramienta de Google

Un dato: se miran 5 mil millones de fotos en Google Photos todos los días… pero hay más cosas que se pueden hacer con ellas, además de mirarlas. Es posible que desees compartir una foto con un amigo, iluminar una imagen oscura, u ocultar una captura de pantalla de tu biblioteca en unos pocos toques. ¿Por qué no hacerlo al momento, entonces?

Mete mano a tus fotos en el momento en que las veas

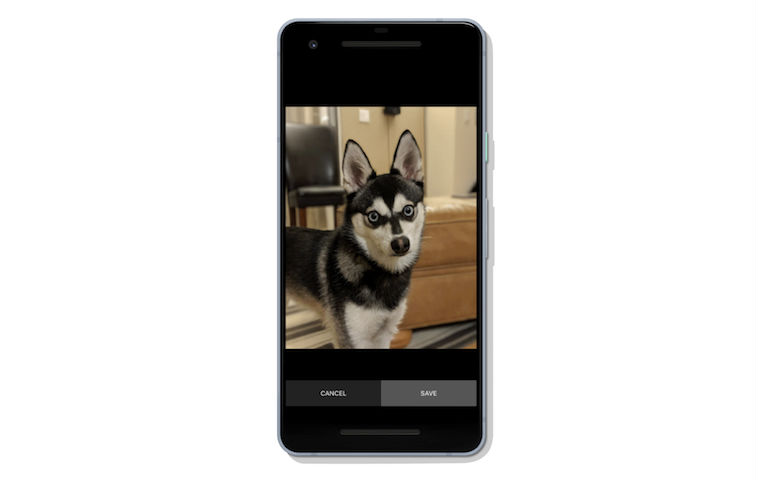

A partir de hoy, comenzarás a ver una serie de acciones sugeridas cuando estés viendo tus fotos. Acciones como una opción para iluminar, compartir, rotar o archivar una imagen. Estas acciones sugeridas se basan en el aprendizaje automático, lo que significa que solo verás estas sugerencias en las fotos relevantes. Podrás tocar estas sugerencias y completar la acción.

Color y blanco/negro en una misma imagen

También a partir de hoy será posible ver tus fotos con nuevos toques de color. En estas creaciones, Google Photos se valdrá de la AI para detectar el sujeto de tu foto y dejarlo solo a él en color —incluida su ropa y lo que tenga en sus manos— mientras el fondo estará en blanco y negro. Podrás ver ya estas creaciones con inteligencia artificial en la pestaña Asistente de Google Photos. Ah: y han mencionado en la conferencia que también se está trabajando en la posibilidad de cambiar el fondo de blanco/negro a color con solo tocarlas.

Experimenta Google Photos en más lugares

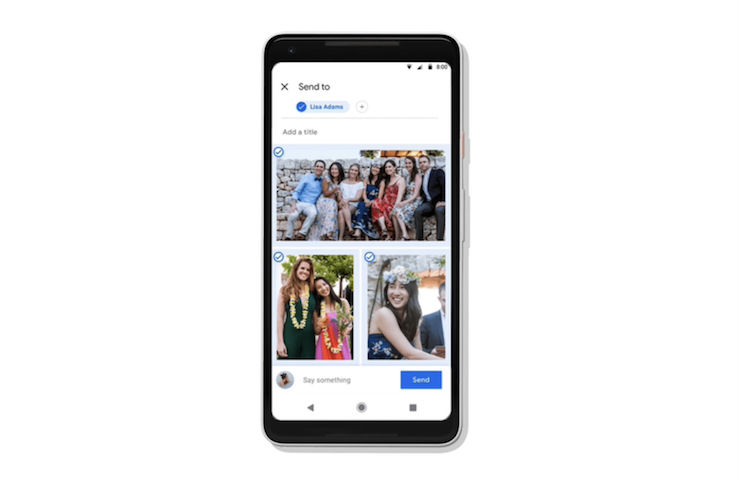

Las personas interactúan con sus fotos en diferentes aplicaciones y dispositivos. Google quiere hacer esto cada vez más fácil, asegurando que estos momentos se extiendan más allá de la aplicación misma y de la experiencia web. Por ejemplo, tal vez te gustaría disfrutar de tus fotos a través de un marco de fotos conectado en tu sala de estar, o guardar los momentos divertidos de un foto booth. Google piensa que debería ser fácil para ti acceder y organizar de manera segura esas fotos.

Por lo anterior, Google ha presentado un nuevo programa de socios de Google Photos que brinda a los desarrolladores las herramientas para admitir Google Photos en sus productos, de modo que las personas puedan elegir la manera o forma en la que accederán a sus fotos cuando las necesiten. Este programa comienza recién hoy, así que ya podrás comenzar a buscar aplicaciones y dispositivos que funcionen con Google Photos en los próximos meses.

Como se ve, estos tres años le han sentado de maravilla a Google Photos, y hay muchas cosas nuevas que vendrán. Fácil, rápida y útil: esta parece ser la santísima trinidad para esta herramienta que espera ser el hogar favorito de tus recuerdos.

Pero eso no ha sido todo. Además,

Google Lens: respuestas en tiempo real a preguntas sobre el mundo que te rodea

Hay mucha información disponible en línea, sí: pero muchas de las preguntas que tenemos son a propósito del mundo que tenemos enfrente. Es por eso que Google comenzó a trabajar en Google Lens, intentando darte las respuestas… allí, donde estás viendo.

El año pasado, Google presentó Lens en el Google Photos y en el Asistente. La gente ya lo está usando para responder a todo tipo de preguntas, especialmente cuando son difíciles de describir en un cuadro “normal” de búsqueda, como «¿qué tipo de perro es ese?» O «¿cómo se llama ese edificio?».

Hoy en Google I/O 2018, han anunciado que Lens ahora estará disponible directamente en la aplicación de la cámara fotográfica y en dispositivos compatibles de LGE, Motorola, Xiaomi, Sony Mobile, HMD/Nokia, Transsion, TCL, OnePlus, BQ, Asus, y por supuesto el Google Pixel. También se han anunciado tres actualizaciones que permitirán a Lens responder a tus más preguntas mejor y más rápidamente:

Primero, una selección de texto inteligente, el cual conecta las palabras que ves con las respuestas y acciones que necesitas. Puedes copiar y pegar textos de recetas, códigos de tarjetas de regalo o contraseñas de Wi-Fi en tu teléfono. Google Lens te ayudará a dar sentido a esas frases o palabras, dándote información y fotos relevantes. Supongamos que estás en un restaurante y ves el nombre de un plato que desconoces: Lens te mostrará una imagen para que te hagas una idea.

En segundo lugar, a veces uno no sólo se pregunta «¿qué es exactamente eso?», sino «¿a qué se parece?». Con la combinación de estilos, si un atuendo o artículo de decoración para el hogar llama tu atención, puedes abrir el objetivo y no solo obtener información sobre ese artículo específico —como las reseñas u opiniones— sino también ver cosas de estilo similar, que se adapten a lo que desees.

Y, en tercer lugar, Lens ahora funciona en tiempo real. Puedes proyectar información de manera proactiva instantáneamente y enlazarla a las cosas que ves. Podrás navegar por el mundo que te rodea, simplemente apuntando con tu cámara. Esto solo es posible con el aprendizaje automático de última generación, el cual utiliza la inteligencia en el dispositivo y los TPU de la nube para identificar miles de millones de palabras, frases, lugares y cosas en una fracción de segundo.

Al igual que los comandos por voz, la visión —lo captado por las cámaras— provocarán un cambio fundamental en la informática. Estas características de Google Lens comenzarán a desplegarse en las próximas semanas.