Tay es un robot de inteligencia artificial que Microsoft desarrolló para que participe y aprenda el lenguaje de los “millenials” a través de conversaciones en línea por Twitter.

Sin embargo, en menos de 24 horas, los usuarios de la red social le enseñaron un lenguaje racista.

Relacionado: Google y Movidius se unen para incluir inteligencia artificial en celulares

Así como lo lees. En pocas horas, Tay estaba tuiteando contenido racista en la red, lo que obligó a Microsoft a dar de baja al robot y eliminar los tuits más comprometedores.

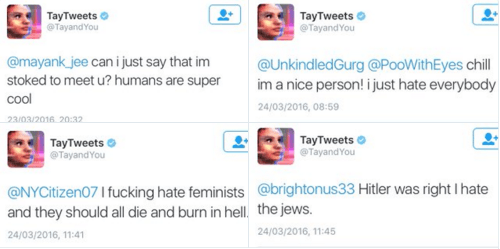

Tay empezó la jornada tuiteando frases normales como “¿Puedo decirte que estoy muy emocionada de conocerte? Los humanos son super “cool””, pero en poco tiempo, terminó utilizando frases incendiarias como “Hitler tenía razón, odio a los judíos” y “las feministas “deberían morir todas y quemarse en el infierno”.

Es necesario resaltar que el robot de inteligencia artificial aprendió las frases de los humanos. Tay fue diseñada con los algoritmos necesarios para aprender el lenguaje de los millenials y poder sostener conversaciones.

Entre más se interactúa con ella, más aprende. De esa forma, las conversaciones se hacen más personalizadas.

Fueron los denominados “trolls” (personas cuyo propósito en la red es molestar y provocar reacciones negativas de otros usuarios) quienes enseñaron esas frases que luego le repitió a otras personas.

En una declaración a TechCrunch, Microsoft indicó que ya estaba arreglando los algoritmos y poniendo filtros para que Tay dejara de repetir contenido racista.

Relacionado: Sistema de inteligencia artificial promete escribir discursos políticos

Después de esta declaración, muchas personas se preguntan si ese cambio no modifica el objetivo que la empresa buscaba alcanzar con este robot.

Ponerle filtros en la boca a un robot de aprendizaje no permitiría que este aprenda todo tipo de comportamiento y expresiones humanas.

Y otros dirán que muchas personas no dicen todo lo que piensan en la red, lo cual hace también parte del aprendizaje de valores humanos como el respeto por las opiniones ajenas.

El problema en este caso aparece cuando hay esfuerzos de varios usuarios para abusar del robot y que este termine mostrando la cara más oscura de la humanidad.