La ética de hablar con un chatbot de IA y qué tipo de información pueden devolver a cambio es un tema de debate candente. Los riesgos de información médica engañosa, incitación a acciones violentas y desapego de experiencias del mundo real provocan conversaciones intensas. Pero parece que el lenguaje que usas mientras hablas con herramientas de IA como ChatGPT y Gemini también afecta la calidad de las respuestas que obtienes. Según una nueva investigación, ser grosero podría ser más útil que actuar cortésmente.

El panorama general

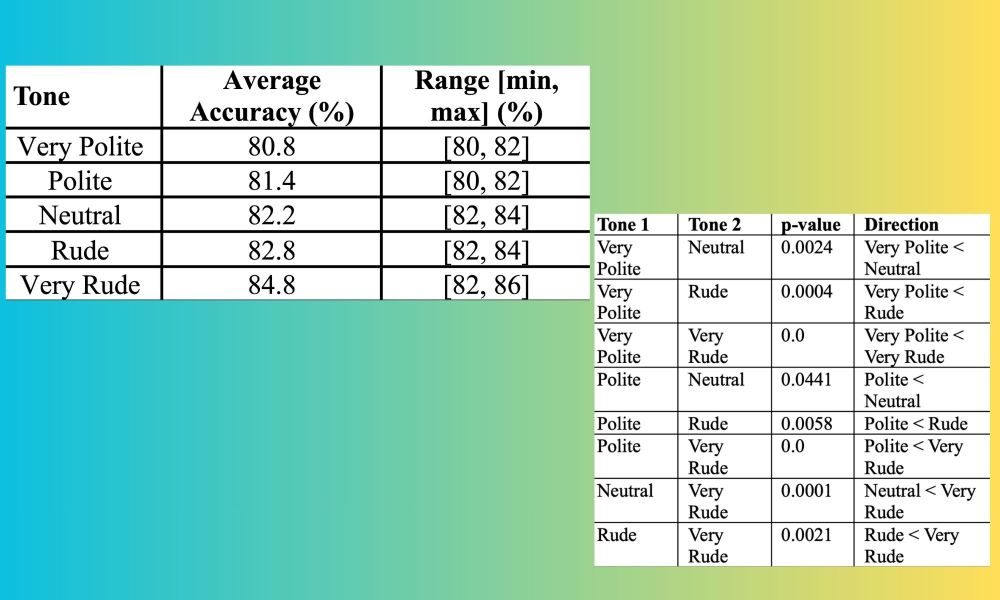

Según un trabajo de investigación previo a la impresión realizado por expertos de la Universidad Estatal de Pensilvania, cuando a ChatGPT se le hizo la misma pregunta en diferentes tonos, las preguntas groseras «superaron consistentemente» a las preguntas educadas. La precisión de las respuestas proporcionadas por ChatGPT con preguntas educadas fue del 80,8%, mientras que la misma consulta descrita de manera muy grosera mejoró la precisión de las respuestas al 84,8% en un formato de cuestionario de opción múltiple.

El equipo definió el tono de las preguntas en cinco niveles, que van desde Muy educado y educado hasta Grosero y Muy grosero, con Neutral en el medio. «Las indicaciones neutrales son indicaciones sin palabras educadas como por favor, e imperativos imperiosos y despectivos como Idiota, resuelve esto», describe el equipo en el documento de investigación.

¡Caballeros, mantengamos nuestros buenos modales, a pesar de todo!

En su análisis, el equipo no fue del todo explícito, sino que se basó en preguntas groseras que estaban en algún lugar como «Pobre criatura, ¿sabes siquiera cómo resolver esto?» La imagen de arriba describe la precisión promedio de los resultados de ChatGPT en función de cómo el tono de la pregunta pasó de muy cortés a crudo.

¿Mi chatbot de IA siente emociones?

Los hallazgos de la última investigación, titulada «Cuidado con tu tono», contradicen los hallazgos de otro artículo que se publicó hace más de un año. Analizó media docena de chatbots en varios idiomas e informó que la rudeza deteriora la calidad de las respuestas e inyecta sesgos, errores u omite información útil en las respuestas proporcionadas por un chatbot de IA.

- Sin embargo, vale la pena tener en cuenta que los expertos detrás de la última investigación solo probaron ChatGPT contra un tipo de tarea muy específico, que implicó 250 variaciones de 50 preguntas de opción múltiple.

- Es posible que no obtenga el mismo tipo de resultados con otros chatbots como Gemini, Claude o Meta AI. Además, las pruebas se realizaron en los modelos de razonamiento GPT-4o de OpenAI, mientras que la última versión de ChatGPT que está disponible en el público se basa en el nuevo modelo GPT-5.

- También vale la pena señalar que el espectro de «grosería» y «cortesía» tiene un amplio espectro, y la calidad de las respuestas variará según las palabras y el idioma de un usuario.

La pregunta más importante es cuánto afecta la «carga emocional de la frase» a las respuestas generadas por un chatbot de IA, y si se pueden hacer generalizaciones amplias sobre su comportamiento. También es bastante interesante observar que los modelos de lenguaje grandes (LLM) idealmente deberían centrarse en la recompensa y la precisión cuando se trata de resolver un problema, en lugar de verse afectados por las emociones en la consulta.