La implementación de los motores de búsqueda con IA, todavía está en pañales, y esa infancia temprana está entregando muchos errores.

Un nuevo informe de investigación de Columbia Journalism Review (CJR) ha descubierto que los modelos de IA de empresas como OpenAI y xAI, cuando se les pregunta sobre un evento noticioso específico, la mayoría de las veces, simplemente inventan una historia o se equivocan en detalles significativos.

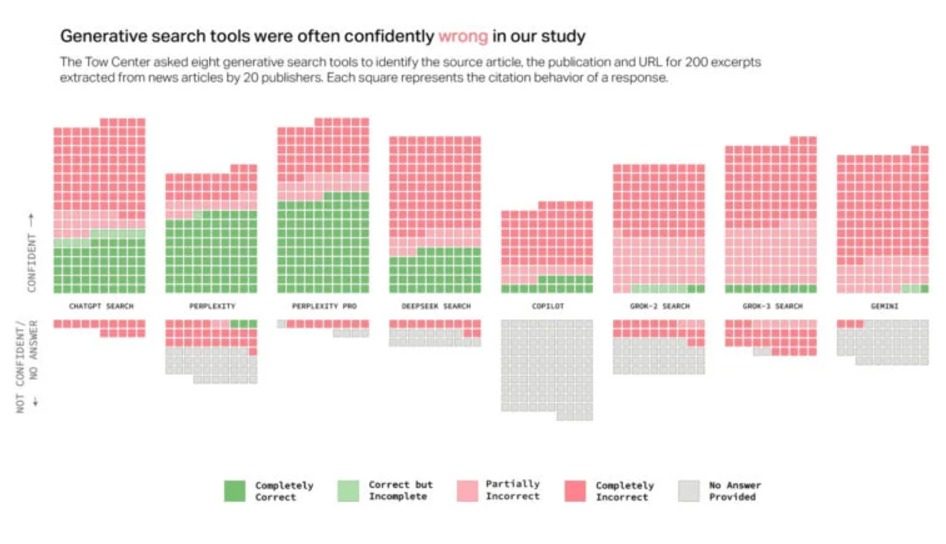

Los investigadores alimentaron a varios modelos con extractos directos de noticias reales y luego les pidieron que identificaran la información, incluido el título del artículo, el editor y la URL. Perplexity devolvió información incorrecta el 37 por ciento de las veces, mientras que en el extremo, Grok de xAI inventó detalles el 97 por ciento de las veces. Los errores incluían ofrecer enlaces a artículos que no iban a ninguna parte porque el bot incluso inventó la URL misma. En general, los investigadores encontraron que los modelos de IA entregaron información falsa para el 60 por ciento de las consultas de prueba.

Los motores de búsqueda de IA que más mienten

Mark Howard, director de operaciones de la revista Time, entregó una opinión categórica sobre la responsabilidad de la mala información que entregan los motores de búsqueda con IA, y no duda también en culpar a los usuarios.

«Si alguien, como consumidor, cree ahora mismo que alguno de estos productos gratuitos va a ser 100 por ciento preciso, entonces qué vergüenza».

CJR dice que uno de cada cuatro estadounidenses ahora usa modelos de IA para la búsqueda. E incluso antes del lanzamiento de las herramientas de IA generativa, más de la mitad de las búsquedas de Google eran de «clic cero», lo que significa que el usuario obtenía la información que necesitaba sin hacer clic en un sitio web.