En los últimos meses, Apple ha publicado un flujo constante de artículos de investigación que detallan su trabajo con la IA generativa. Hasta ahora, Apple ha mantenido la boca cerrada sobre qué es exactamente lo que se está cocinando en sus laboratorios de investigación, mientras que circulan rumores de que Apple está en conversaciones con Google para licenciar su Gemini AI para iPhones.

Pero ha habido un par de adelantos de lo que podemos esperar. En febrero, un documento de investigación de Apple detalló un modelo de código abierto llamado MLLM-Guided Image Editing (MGIE) que es capaz de editar medios utilizando instrucciones de lenguaje natural de los usuarios. Ahora, otro trabajo de investigación sobre la interfaz de usuario de Ferret ha hecho que la comunidad de IA se vuelva loca.

La idea es implementar una IA multimodal (que entienda textos y activos multimedia) para comprender mejor los elementos de una interfaz de usuario móvil. y lo más importante, ofrecer consejos prácticos. Ese es un objetivo crítico a medida que los ingenieros compiten para hacer que la IA sea más útil para un usuario promedio de teléfonos inteligentes que el estado actual de «truco de salón».

En esa dirección, el mayor impulso es desconectar las capacidades de IA generativa de la nube, poner fin a la necesidad de una conexión a Internet e implementar cada tarea en el dispositivo para que sea más rápido y seguro. Tomemos, por ejemplo, Gemini de Google, que se ejecuta localmente en los teléfonos de las series Google Pixel y Samsung Galaxy S24 -y pronto, en los teléfonos OnePlus- y realiza tareas como el resumen y la traducción.

¿Qué es la interfaz de usuario de Ferret de Apple?

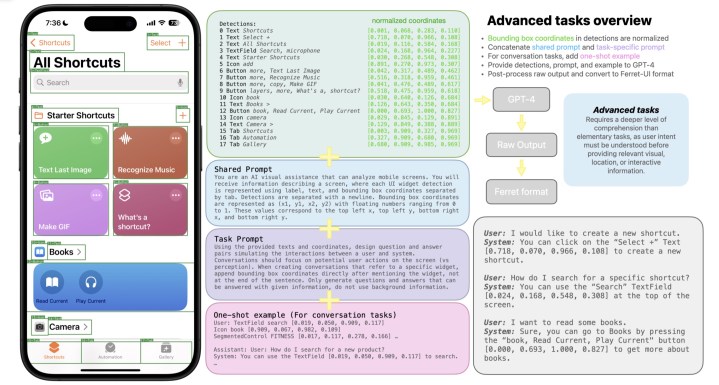

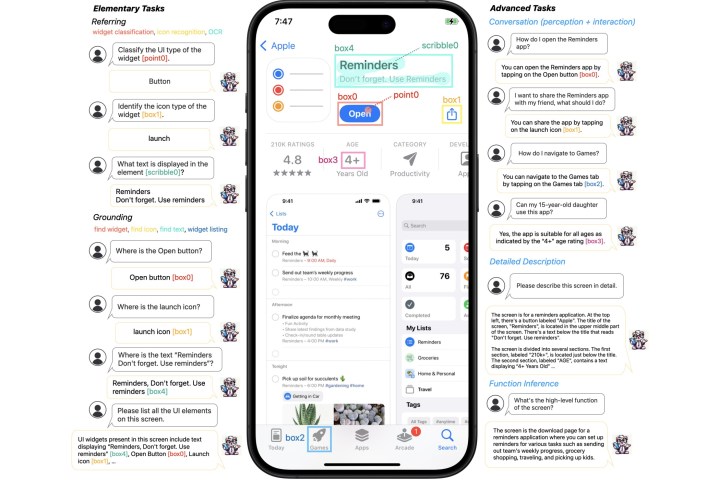

Con Ferret-UI, Apple aparentemente tiene como objetivo combinar la inteligencia de un modelo de IA multimodal con iOS. En este momento, la atención se centra en tareas más «elementales» como «reconocimiento de iconos, búsqueda de texto y lista de widgets». Sin embargo, no se trata solo de dar sentido a lo que se muestra en la pantalla de un iPhone, sino también de entenderlo lógicamente y responder a las consultas contextuales planteadas por los usuarios a través de sus capacidades de razonamiento.

La forma más fácil de describir las capacidades de la interfaz de usuario de Ferret es como un sistema inteligente de reconocimiento óptico de caracteres (OCR) impulsado por IA. «Después de entrenar con los conjuntos de datos seleccionados, Ferret-UI exhibe una comprensión sobresaliente de las pantallas de la interfaz de usuario y la capacidad de ejecutar instrucciones abiertas», señala el artículo de investigación. El equipo detrás de Ferret UI lo ha ajustado para adaptarse a «cualquier resolución».

Puedes hacer preguntas como «¿Es esta aplicación segura para mi hijo de 12 años?» mientras navegas por la App Store. En tales situaciones, la IA leerá la clasificación por edades de la aplicación y, en consecuencia, proporcionará la respuesta. No se especifica cómo se serviría la respuesta, texto o audio, ya que el documento no menciona a Siri ni a ningún asistente virtual.

Apple no se alejó demasiado del árbol GPT

Pero las ideas son mucho más panorámicas e inteligentes. Pregúntale «¿Cómo puedo compartir la aplicación con un amigo?» y la IA resaltará el icono de «compartir» en la pantalla. Por supuesto, le dará una idea general de lo que parpadea en la pantalla, pero al mismo tiempo, analizará lógicamente los activos visuales en la pantalla, como cuadros, botones, imágenes, íconos y más. Esa es una gran victoria de accesibilidad.

Si desea escuchar los términos técnicos, bueno, el documento se refiere a estas capacidades como «conversación de percepción», «inferencia funcional» y «conversación de interacción». Una de las descripciones del trabajo de investigación resume perfectamente las posibilidades de la interfaz de usuario de Ferret, describiéndola como «el primer MLLM diseñado para ejecutar tareas precisas de referencia y conexión a tierra específicas de las pantallas de interfaz de usuario, mientras interpreta hábilmente y actúa sobre instrucciones de lenguaje abiertas».

Como resultado, puede describir capturas de pantalla, decir qué hace un activo en particular cuando se toca y discernir si algo en la pantalla es interactivo con entradas táctiles. Ferret UI no es únicamente un proyecto interno. En cambio, para la parte de razonamiento y descripción, se basa en la tecnología GPT-4 de OpenAI, que impulsa ChatGPT, junto con un montón de otros productos conversacionales que existen.

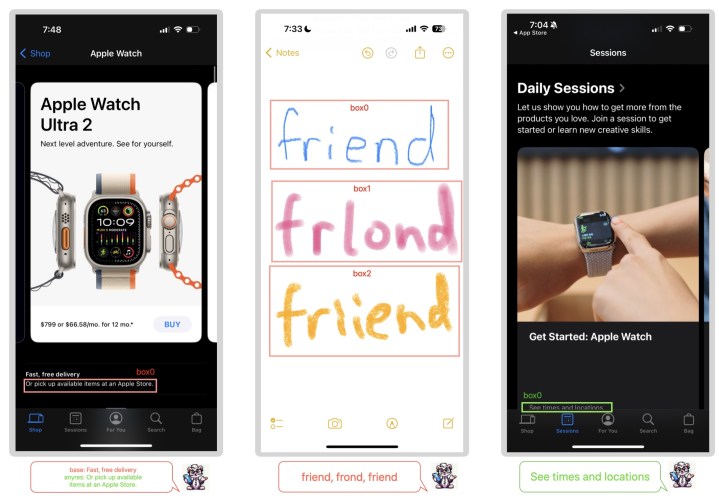

En particular, la versión particular propuesta en el documento es adecuada para múltiples relaciones de aspecto. Además de sus capacidades de análisis y razonamiento en pantalla, el documento de investigación también describe algunas capacidades avanzadas que son bastante sorprendentes de imaginar. Por ejemplo, en la siguiente captura de pantalla, parece capaz no solo de analizar texto escrito a mano, sino que también puede predecir la versión correcta a partir del garabato mal escrito del usuario.

También es capaz de leer con precisión el texto que está cortado en el borde superior o inferior y que, de otro modo, requeriría un desplazamiento vertical. Sin embargo, no es perfecto. En ocasiones, identifica erróneamente un botón como una pestaña y lee erróneamente los recursos que combinan imágenes y texto en un solo bloque.

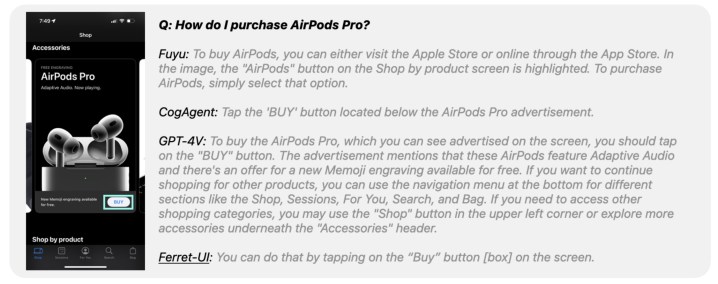

Cuando se enfrentó al modelo GPT-4V de OpenAI, la interfaz de usuario de Ferret ofreció un nivel impresionante de resultados de interacción conversacional cuando se le hicieron preguntas relacionadas con el contenido en pantalla. Como se puede ver en la imagen de abajo, Ferret UI prefiere respuestas más concisas y directas, mientras que GPT-4V escribe respuestas más detalladas.

La elección es subjetiva, pero si le preguntara a una IA: «¿Cómo compro la zapatilla que aparece en la pantalla?», preferiría que me diera los pasos correctos en la menor cantidad de palabras posible. Pero Ferret UI funcionó admirablemente no solo para mantener las cosas concisas, sino también para ser precisas. En la tarea antes mencionada, Ferret UI obtuvo una puntuación del 91,7% en los resultados de interacción conversacional, mientras que GPT-4V estaba solo ligeramente por delante con un 93,4% de precisión.

Un universo de posibilidades intrigantes

La interfaz de usuario marca un impresionante debut de la IA que puede dar sentido a las acciones en pantalla. Ahora, antes de que nos entusiasmemos demasiado con las posibilidades aquí, no estamos seguros de cómo exactamente Apple pretende integrar esto con iOS, o si se materializará en absoluto, por múltiples razones. Bloomberg informó recientemente que Apple era consciente de estar rezagada en la carrera de la IA, y eso es bastante evidente por la falta de productos nativos de IA generativa en el ecosistema de Apple.

En primer lugar, los rumores de que Apple incluso está considerando un acuerdo de licencia de Gemini con Google u OpenAI son una señal de que el propio trabajo de Apple no está al mismo nivel que el de la competencia. En tal escenario, aprovechar el trabajo que Google ya ha hecho con Gemini (que ahora está tratando de reemplazar al Asistente de Google en los teléfonos) sería más inteligente que impulsar un producto de IA a medias en iPhones y iPads.

Apple claramente tiene ideas ambiciosas y continúa trabajando en ellas, como lo demuestran los experimentos detallados en múltiples trabajos de investigación. Sin embargo, incluso si Apple logra cumplir las promesas de la interfaz de usuario de Ferret dentro de iOS, aún equivaldría a una implementación superficial de IA generativa en el dispositivo.

Sin embargo, las integraciones funcionales, incluso si se limitan solo a aplicaciones internas preinstaladas, podrían producir resultados sorprendentes. Por ejemplo, supongamos que está leyendo un correo electrónico mientras la IA ya ha evaluado el contenido en pantalla en segundo plano. Mientras lees el mensaje en la aplicación Correo, puedes pedirle a la IA con un comando de voz que haga una entrada de calendario y la guarde en tu agenda.

No necesariamente tiene que ser una tarea súper compleja de varios pasos que involucre a más de una aplicación. Supongamos que estás mirando la página de conocimiento de la Búsqueda de Google de un restaurante y, simplemente diciendo «llamar al lugar», la IA lee el número de teléfono en pantalla, lo copia en el marcador e inicia una llamada.

O bien, digamos que estás leyendo un tweet sobre una película que se estrena el 6 de abril y le dices a la IA que cree un acceso directo dirigido a la aplicación Fandango. O bien, una publicación de una playa en Vietnam inspira tu próximo viaje en solitario, y un simple «resérvame un boleto para Con Dai» te lleva a la aplicación de Skyscanner con todas tus entradas ya completadas.

Pero todo esto es más fácil decirlo que hacerlo y depende de múltiples variables, algunas de las cuales podrían estar fuera del control de Apple. Por ejemplo, las páginas web plagadas de ventanas emergentes y anuncios intrusivos harían casi imposible que la interfaz de usuario de Ferret hiciera su trabajo. Pero en el lado positivo, los desarrolladores de iOS se adhieren estrictamente a las pautas de diseño establecidas por Apple, por lo que es probable que la interfaz de usuario de Ferret haga su magia de manera más eficiente en las aplicaciones de iPhone.

Aun así, sería una victoria impresionante. Y dado que estamos hablando de una implementación en el dispositivo estrechamente horneada a nivel del sistema operativo, es poco probable que Apple cobre por la comodidad, a diferencia de los productos de IA generativa convencionales como ChatGPT Plus o Microsoft Copilot Pro. ¿iOS 18 finalmente nos daría un vistazo a un iOS reimaginado sobrealimentado con inteligencia artificial? Tendremos que esperar hasta la Conferencia Mundial de Desarrolladores de Apple 2024 para averiguarlo.