Antes del Día Mundial de la Concienciación sobre la Accesibilidad tanto Apple como Google están lanzando nuevas herramientas para ayudar a personas con movilidad reducida a usar sus productos.

Apple está brindando soporte de seguimiento ocular a modelos recientes de iPhones y iPads, así como atajos vocales personalizables, hápticos musicales, señales de movimiento de vehículos y más.

Los de Cupertino ahora dan a sus usuarios la capacidad de usar la cámara frontal en iPhones o iPads (al menos aquellos con el chip A12 o posterior) para navegar por el software sin hardware o accesorios adicionales. Con esto habilitado, las personas pueden mirar su pantalla para moverse a través de elementos como aplicaciones y menús, y luego detenerse en un elemento para seleccionarlo.

Dado que Apple ya admitía el seguimiento ocular en iOS y iPadOS con dispositivos de detección ocular conectados, la novedad de hoy es la capacidad de hacerlo sin hardware adicional.

Otra mejora que llega a las interacciones vocales es «Listen for Atypical Speech», que hace que los iPhones y iPads utilicen el aprendizaje automático en el dispositivo para reconocer patrones de voz y personalizar su reconocimiento de voz en torno a su forma única de vocalizar.

Para aquellos que son sordos o tienen problemas de audición, Apple está llevando la háptica a los reproductores de música en el iPhone, comenzando con millones de canciones en su propia aplicación Música. Cuando está habilitado, la háptica de música reproducirá golpes, texturas y vibraciones especializadas junto con el audio para brindar una nueva capa de sensación.

Los conductores con discapacidades necesitan mejores sistemas en sus automóviles, y Apple está abordando algunos de los problemas con sus actualizaciones de CarPlay. El control por voz y los filtros de color están llegando a la interfaz de los vehículos, lo que facilita el control de las aplicaciones hablando y para las personas con discapacidad visual la visualización de menús o alertas. Con ese fin, CarPlay también está recibiendo soporte de texto en negrita y grande, así como reconocimiento de sonido para ruidos como sirenas o bocinazos.

Para aquellos que se marean mientras usan sus iPhones o iPads en vehículos en movimiento, una nueva función llamada Señales de movimiento del vehículo podría aliviar parte de esa incomodidad. Dado que el mareo por movimiento se basa en un conflicto sensorial al mirar contenido estacionario mientras se está en un vehículo en movimiento, la nueva función está destinada a alinear mejor los sentidos en conflicto a través de puntos en pantalla. Cuando están habilitados, estos puntos se alinearán en los cuatro bordes de la pantalla y se balancearán en respuesta al movimiento que detecte. Si el automóvil avanza o acelera, los puntos se balancearán hacia atrás como si fueran una reacción al aumento de velocidad en esa dirección.

Google también se pone a tono con la accesibilidad

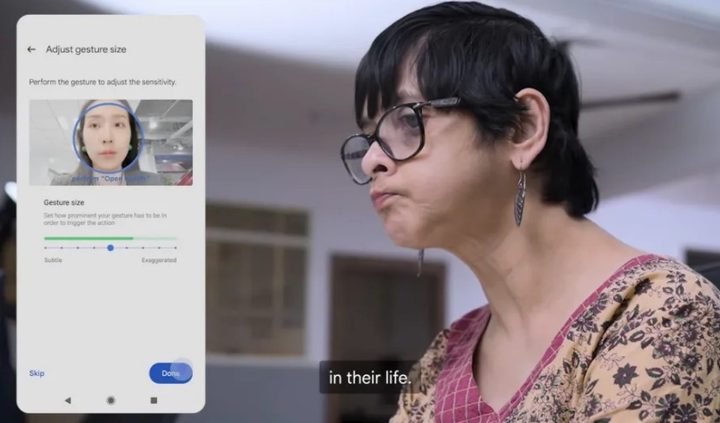

Google ha anunciado que ha abierto más código para Project Gameface, lo que permite a los desarrolladores crear aplicaciones de Android que puedan usar la tecnología.

La herramienta se basa en la cámara frontal del teléfono para rastrear las expresiones faciales y los movimientos de la cabeza, que se pueden usar para controlar un cursor virtual. Un usuario podría sonreír para «seleccionar» elementos en la pantalla, por ejemplo, o levantar la ceja izquierda para volver a la pantalla de inicio en un teléfono Android. Además, los usuarios pueden establecer umbrales o tamaños de gestos para cada expresión, de modo que puedan controlar la prominencia de sus expresiones para desencadenar una acción específica del mouse.