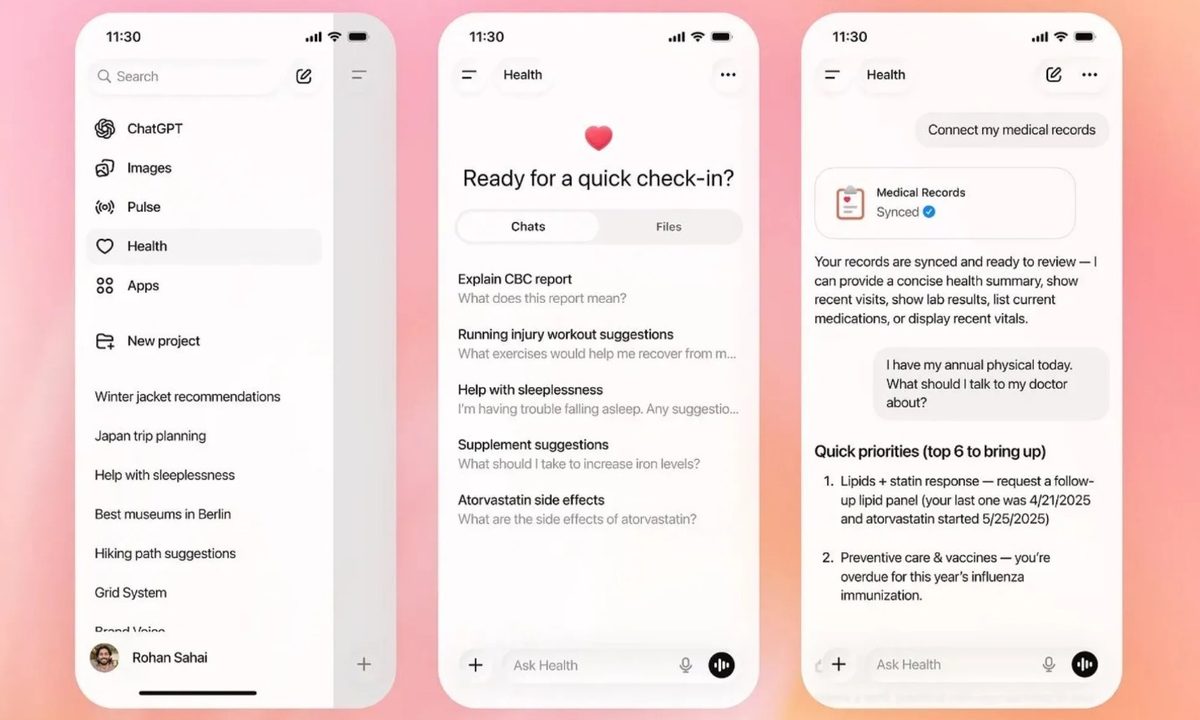

A principios de este mes, OpenAI presentó un nuevo espacio centrado en la salud dentro de ChatGPT, presentándolo como una forma más segura para que los usuarios puedan hacer preguntas sobre temas sensibles como datos médicos, enfermedades y fitness. Una de las características principales destacadas en el lanzamiento fue la capacidad de ChatGPT Health para analizar datos de aplicaciones como Apple Health, MyFitnessPal y Peloton para identificar tendencias a largo plazo y ofrecer resultados personalizados. Sin embargo, un nuevo informe sugiere que OpenAI podría haber exagerado la eficacia de esta función para extraer información fiable de esos datos.

Según las primeras pruebas realizadas por Geoffrey A. Fowler de The Washington Post, cuando ChatGPT Health obtuvo acceso a una década de datos de Apple Health, el chatbot calificó la salud cardíaca del reportero con un suspenso. Sin embargo, tras revisar la evaluación, un cardiólogo la calificó de «infundada» y afirmó que el riesgo real de enfermedad cardíaca en el periodista era extremadamente bajo.

El Dr. Eric Topol, del Scripps Research Institute, ofreció una evaluación directa de las capacidades de ChatGPT Health, afirmando que la herramienta no está preparada para ofrecer consejos médicos y que se basa demasiado en métricas poco fiables de relojes inteligentes. La calificación de ChatGPT se basó en gran medida en las estimaciones del Apple Watch sobre VO2 max y variabilidad de la frecuencia cardíaca, ambas con limitaciones conocidas y que pueden variar significativamente entre dispositivos y configuraciones de software. Investigaciones independientes han encontrado que las estimaciones de VO2 max del Apple Watch suelen ser bajas, pero ChatGPT sigue tratándolas como indicadores claros de mala salud.

ChatGPT Health otorgó diferentes calificaciones para los mismos datos

Los problemas no se detuvieron ahí. Cuando el reportero pidió a ChatGPT Health que repitiera el mismo ejercicio de calificación, la puntuación fluctuó entre un F y un B en las conversaciones, con el chatbot a veces ignorando informes recientes de análisis de sangre a los que tenía acceso y olvidando detalles básicos como la edad y el género del reportero. Claude for Healthcare de Anthropic, que también debutó a principios de este mes, mostró consistencias similares, asignando notas que oscilaban entre un C y un B menos.

Tanto OpenAI como Anthropic han recalcado que sus herramientas no están destinadas a sustituir a los médicos y solo proporcionan contexto general. Aun así, ambos chatbots ofrecieron evaluaciones seguras y altamente personalizadas de la salud cardiovascular. Esta combinación de autoridad e inconsistencia podría asustar a usuarios sanos o tranquilizar falsamente a los que no están sanos. Aunque la IA podría desbloquear con el tiempo valiosos conocimientos a partir de datos de salud a largo plazo, las primeras pruebas sugieren que introducir años de datos de seguimiento de fitness en estas herramientas genera actualmente más confusión que claridad.