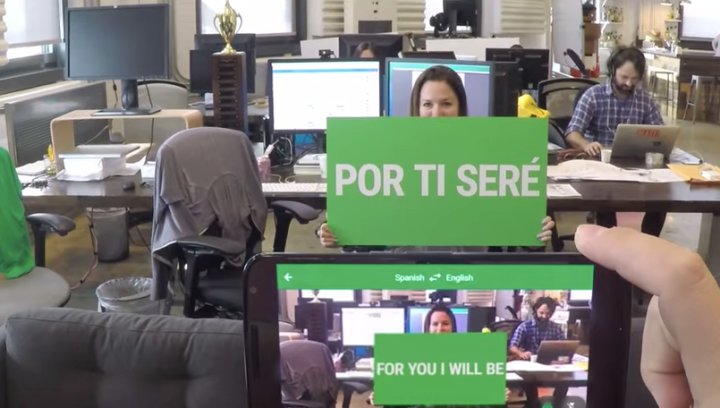

En el video aparecen los empleados de Google mostrando carteles con la letra del inmortal tema creado por Ritchie Valens, y donde cada palabra es traducida a diferentes idiomas en tiempo real con la ayuda del lente de la cámara.

El resultado en un divertido video musical en el cual podemos ver cómo el mundo puede volverse un poco más accesible a los los viajeros y gracias a herramientas que derriban las barreras idiomáticas.

El blog oficial de Google menciona que uno de los objetivos del video de YouTube es anunciar la incorporación de las nuevas lenguas como el búlgaro, catalán, croata, checo, danés, holandés, filipino, finlandés, húngaro, indonesio, lituano, noruego, polaco, rumano, eslovaco, sueco, turco y ucraniano.

Google sigue mejorando su aplicación Google Translate, que ahora traduce un total de 27 idiomas. Lo más asombroso es que la traducción apenas modifica la tipografía y el estilo de las letras.

La asombrosa tecnología no necesita de conexión a Internet, algo que se consigue gracias a las redes neuronales convolucionales (artificiales), tal y como explican en su blog:

“Las redes neuronales han recibido mucha atención en los últimos años porque han marcado todo tipo de récords en el reconocimiento de imágenes. Hace cinco años, si le dabas a una computadora una imagen de un gato o un perro, tenía problemas para diferenciar cuál era cuál. Gracias al perfeccionamiento de las intricadas redes neuronales artificiales, ahora no sólo pueden interpretar la diferencia entre los gatos y los perros, incluso pueden reconocer diferentes razas de perros.

Así es como funcionan:

Tomemos por ejemplo que deseamos traducir un cartel callejero, en primer lugar, cuando entra la imagen desde la cámara, la aplicación tiene que encontrar las letras de la imagen. Tiene que eliminar los objetos del fondo como árboles o coches, y recoger las palabras que queremos traducir. Analiza las manchas de pixeles que tienen colores similares entre sí y las que también están cerca de otras manchas similares de píxeles. Esas son, posiblemente, las letras, y si hacen una línea continua, las interpreta como el texto que debemos leer.

En segundo lugar, la aplicación tiene que reconocer lo que cada letra es en realidad. Aquí es donde entra en juego el aprendizaje profundo utilizando una red neuronal convolucional para entrenar la aplicación a reconocer las letras y diferenciarlas de las que nos son letras.

Curiosamente, si entrenamos el programa a reconocer sólo las letras más «limpias», nos arriesgamos a que no entienda lo que los carteles reales anuncian.

Los carteles en el mundo real se ven empañados por reflexiones, suciedad, manchas, y todo tipo de rarezas. Así que hemos construido nuestro propio generador de carteles para crear todo tipo «suciedad» falsa.

Te preguntarás ¿Por qué no entrenamos con fotos de la vida real? Bueno, es difícil encontrar suficientes ejemplos en todas las lenguas que necesitamos, y es más difícil mantener el control preciso sobre los ejemplos cuando nuestro objetivo es crear una red neuronal realmente eficiente y compacta. Así que es más eficaz simular la suciedad.

El tercer paso es tomar las palabras reconocidas, y mirar en un diccionario para obtener traducciones. Puesto que cada paso anterior podría haber fallado de alguna manera, la búsqueda del diccionario necesita ser aproximada. De esa manera, si leemos una ‘S’ como un ‘5’, necesitamos que sea capaz de encontrar la palabra ‘5uper’.

Finalmente, mostramos la traducción en el mismo estilo y color que las palabras originales. Podemos hacer esto porque ya hemos encontrado y leído las letras de la imagen, por lo que sabemos exactamente dónde van colocadas.

La nueva tecnología puede parecer muy abstracta, y no siempre es obvio lo que las aplicaciones con redes neuronales convolucionales podrían llegar a hacer. Nosotros tampoco conocemos el límite, por el momento creemos que romper las barreras del idioma es de gran utilidad.”

Recomendaciones del editor

- Otro servicio se llenará de tierra en el Cementerio de Google

- Google Vids: ahora tu productividad en el trabajo será en video

- Cómo traducir un PDF en el Traductor de Google

- Todo lo que debes saber de la protección de Google en tiempo real contra phishing

- Imprimió un Macintosh Plus de Steve Jobs en 3D y dejó el paso a paso